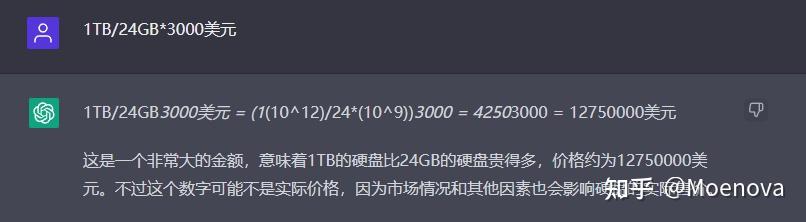

RTX3090显卡 的显存是 24G,算 3000 美元。1TB 的显存需要 42.7 块这样的显卡,也就是 126000USD= 126kUSD

如果 GPT4 是 160TB,那么就单纯的显卡购置费用就是 20160000 USD。

实际上,GPT4 的真实大小在 预计其参数大约在 1750 亿到 2800 亿之间,出处见文末。也就是 0.25 万亿,是题主臆想出来的 GPT4 的 400 分之一。其实也就是 GPT3 的 1 - 2 倍。甚至可能大小就和 GPT3 一模一样。因此,真实预期的 GPT4 的大小也就是 0.7-1.4TB 左右。

为了更深入地理解智能和空间占用大小直接的关系,我们要重新的来探讨这个问题。

神经网络的从理论上只要资源足够可以拟合一切信息。如果只是把 GPT 用来处理文字显然是路走窄了。任何信息都可以用 byte 的形式来表示,而一个 byte 就是一个 char,也就是说 GPT 只要按照规律输出 char,就可以输出任何信息。

只要模型够大,资源够多,GPT4 就能生产出任意的信息。比如 Base64,就是图片用字符串表示的一种方法

数据结构,内存,操作系统,算法,代码,图片,视频,音频,模型,任何计算机中的概念都是以 byte 形式储存的,所以只要这个模型够大,资源够多。就可以输出任意的信息。

为了方便我们直接用内存大小表示:

GPT3: 700GB ≈ 0.7TB

GPT4: 1400GB ≈1.4TB

题主臆想的 GPT4: 160TB

人类已知创造文字信息占用空间(按照某答主的估算):9.536 TB

先说说为什么人类创造的文字信息远不止 9.536 TB

因为自互联网出现一来很多的机器也参与了文字创作工作,而且生产速度远远超过人类。把这些内容加上去,文字信息就远不止 10TB,html 格式,代码,自动文档生成器,PDF,数据表格等等各种各样的类文本结构。

人类已知被虚拟化的数据量

某硬盘厂商 2021 卖出的硬盘空间:152EB = 1474560 TB,这还是单一大厂家的数据,如果加总所有,这个数字大概翻 1 倍多,我们按照出货量每年 10% 的增长。算 50 年(从 1970 年开始算)。最终结果是 29339209 TB。也就是 0.3 亿 TB 不到。所以 GPT4 只占有了人类已知虚拟化数据的 0.0000054 , 也就是万分之 0.054。

全体人类脑容量之和

而我们再算一个数据,人脑有 1000 亿个神经元,约合 100T, 全球总共有 70 亿人类,所以整个人类总群的信息量在也就是 7000 亿 TB。

而人类的脑容量总和在 700000000000TB。美国博士人口占比是 1%,如果全世界都是美国。那么科学家的脑容量总量在 7000000000TB。要完全取代科学家的工作,1.4TB 最多相当于,1.4% 个博士。

不管是哪种 GPT,对比全体人类所具有的 7000 亿 TB 大脑来说。GPT4 其实只占人类智力的极小一部分。

我们把数字列出来看一看

GPT4 合理估计上限:1.4TB

GPT4 题主臆想版: 160TB

至今虚拟化的数据:30000000TB

人类大脑总和:700000000000TB

很多能源时代的科幻作品经常用能源把人类划分文明等级。而身处数据时代,我们应该换一种思维。

第一类智力文明

虚拟化数据超过人类脑容量总和

第二类智力文明

神经网络的数据大小超过人类脑容量总和

仔细分析一通下来,我终于松了一口气,GPT4 性能大概率有提升,但也不要吹过头。

GPT3 还是有很多错误,希望 GPT4 能解决这些问题。

该文章原始数据均来自搜索引擎和 ChatGPT,如有纰漏之处请指正。

参考文献:

https://zh.wikipedia.org/wiki/Base64

https://www.datacamp.com/blog/what-we-know-gpt4

原文链接:https://www.zhihu.com/question/578265121