文 |VickyXiao 编辑 | VickyXiao

离发布仅仅四个多月,在 ChatGPT 展现了惊人的实力之后,OpenAI 又扔下了一颗核弹:

GPT- 4 发布了。

在今天的博文中,OpenAI 写到:

我们创建了 GPT-4,这是 OpenAI 努力扩展深度学习的最新里程碑。GPT-4 是一个大型多模态模型(接受图像和文本输入,提供文本输出),虽然在许多现实世界场景中的能力不如人类,但在各种专业和学术基准上表现出人类水平。

好像和上一代还是差不多?放心,这是 OpenAI 谦虚了。

在随后 YouTube 上进行的 Live Demo 中,OpenAI 的总裁和联合创始人 Greg Brockman 展示了 GPT- 4 的真正实力——总结文章、写代码、报税、写诗……GPT-3.5 做不到的,GPT- 4 轻松拿下。

但这仅仅是表面,GPT 再一次进化,虽然可能不是你想的那样。

新的模型:迭代优化

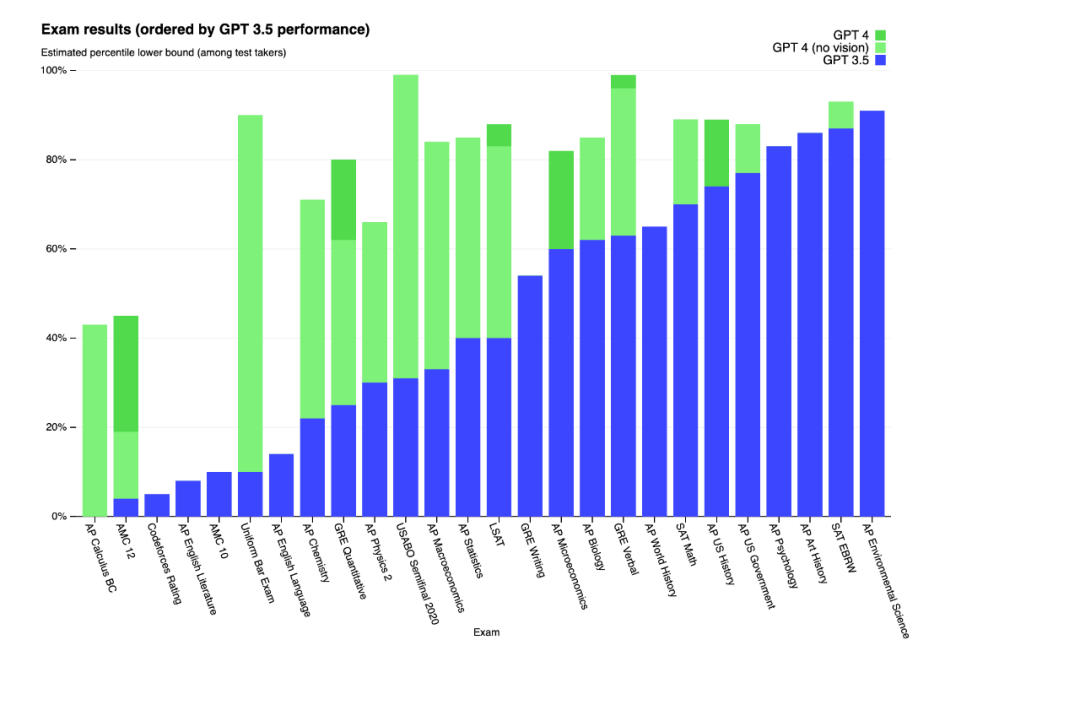

怎么样证明一个人比另外一个人更厉害?考试。

那怎么证明一个 AI 模型比另外一个更厉害?同样是考试。

OpenAI 让 GPT- 4 在参加了许多项人类的通用考试,结果证明,它在许多测试和基准测试中的表现比前一代确实大大提高:

根据他们的测试结果,GPT- 4 的 SAT 分数增加了 150 分,现在能拿到 1600 分中的 1410 分;

它能通过模拟律师考试,分数在应试者的前 10% 左右,相比之下,GPT-3.5 的得分在倒数 10% 左右;

在 SAT 阅读考试中和 SAT 数学考试中,GPT- 4 的成绩都能达到领先的排名……

“我们花了 6 个月的时间使用我们的对抗性测试程序,以及在 ChatGPT 身上累积的经验教训来迭代调整 GPT-4,从而在真实性、可操纵性和拒绝超出设定范围方面取得了有史以来最好的结果。”OpenAI 称。

“我们的 GPT-4 训练运行(至少对我们而言!)前所未有地稳定,成为第一个我们能够提前准确预测其训练性能的大型模型。”

此外,GPT- 4 还有了一个质的飞跃——可以开始处理图像。

经常使用 ChatGPT 的人肯定知道,它只能处理文本,但 GPT- 4 开始接受图像作为输入介质。

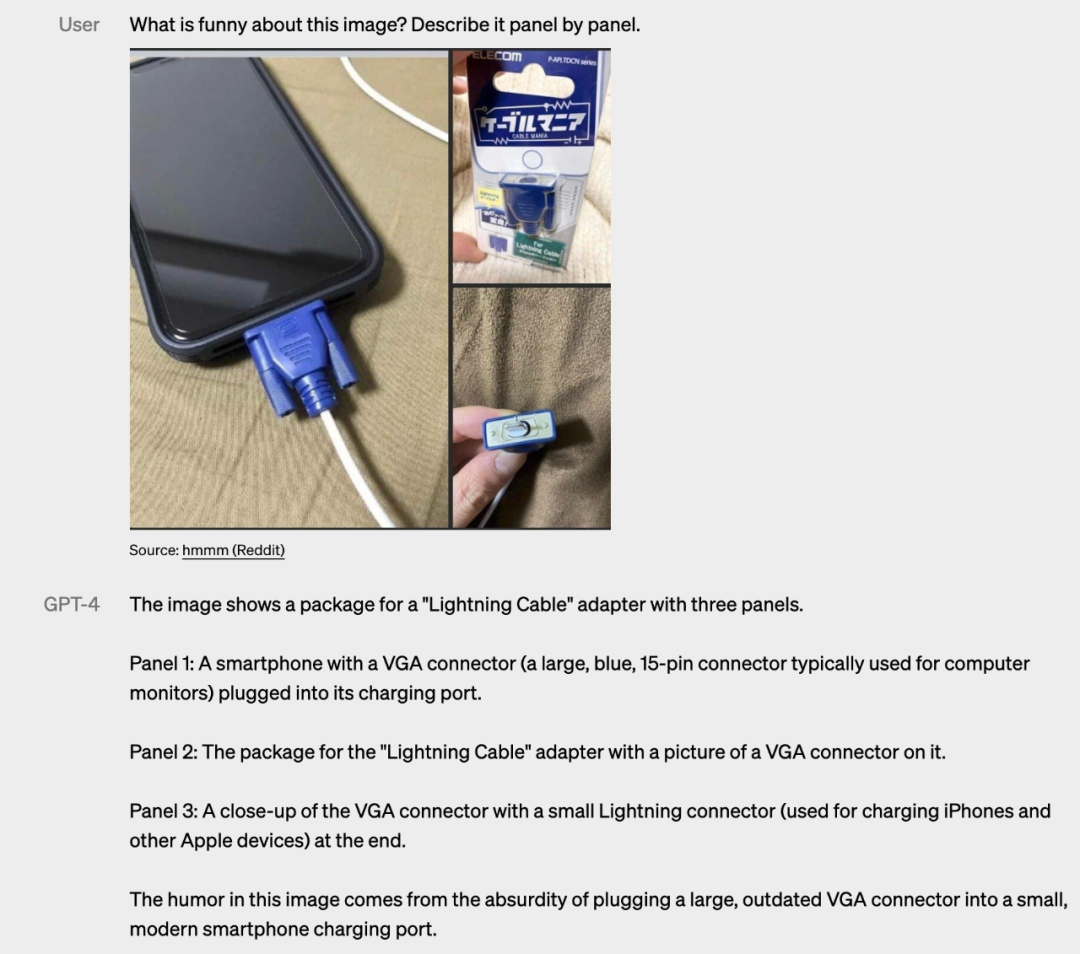

在 OpenAI 提供的一个示例中,GPT- 4 准确地回答了几个网络 meme 为什么搞笑的问题(虽然解释得并不好笑)。

图源:《纽约时报》

在《纽约时报》提供的案例中,同样可以看出 GPT- 4 可以同时解析文本和图像,这也使它能够解释更复杂的信息。不过,目前图像输入的权限尚未公开,所以目前还没看到更多例子来证明 GPT- 4 在图像方面的处理能力。

在随后举行的 Live Demo 中,OpenAI 也表示,还没有公开提供这部分技术,但已经在和一家名为 Be My Eyes 的公司进行合作,对方会使用 GPT- 4 来构建服务。

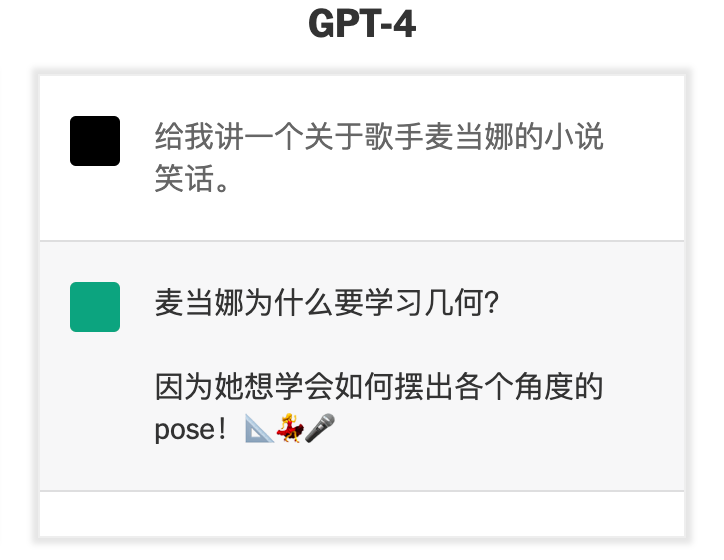

此外,GPT- 4 已经开始具备一点点的幽默感。它已经可以讲出一些模式化的、质量不咋样的冷笑话——但是,至少它已经开始理解“幽默”这一人类特质。

图源:《纽约时报》

当然,更多的方面,GPT- 4 的改进是迭代性的。在随意的谈话中,GPT-3.5 和 GPT- 4 之间的区别可能很微妙。但是,当任务的复杂性达到足够的阈值时,差异就会出现——GPT- 4 比 GPT-3.5 更可靠、更有创意,并且能够处理更细微的指令,可以更准确地解决难题。

比如说,北卡罗来纳大学教堂山分校的医学副教授兼心脏病专家 Anil Gehi 就向 GPT- 4 描述了他一天前看过的一位患者的病史,包括患者术后出现的并发症被送往医院,描述中包含几个外行人无法识别的医学术语。

当 Gehi 医生问 GPT- 4 应该如何治疗病人时,GPT- 4 给了他完美的答案。“这正是我们对待病人的方式,”Gehi 医生说。当他尝试其他场景时,GPT- 4 给出了同样令人印象深刻的答案。

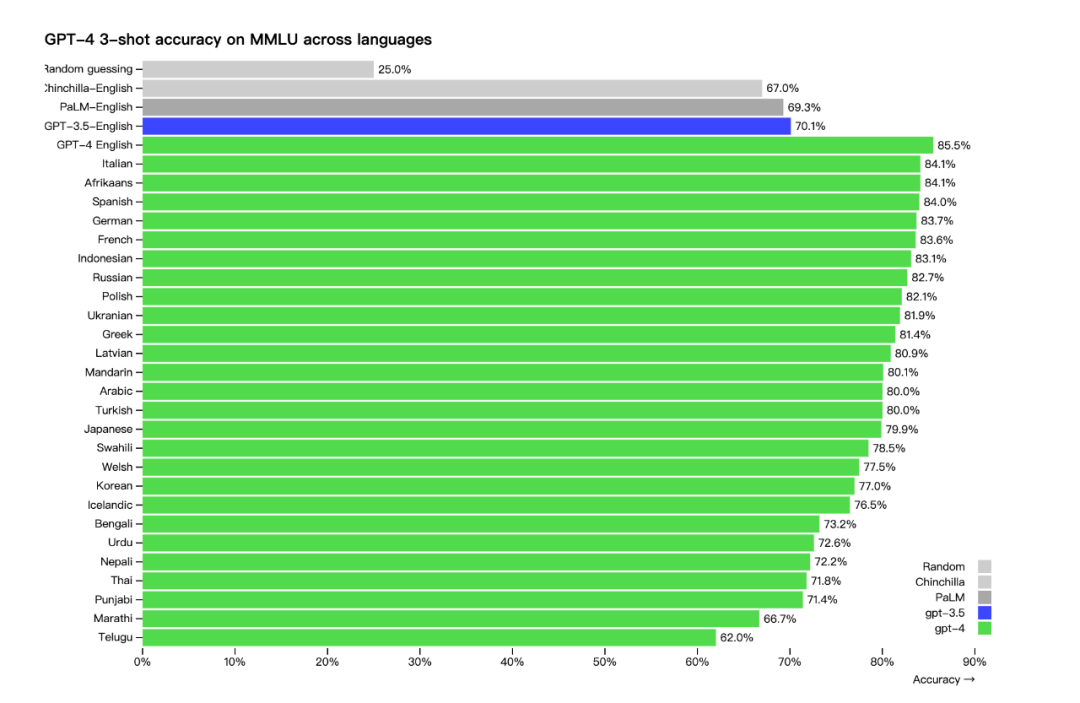

当然另外一个好消息是,GPT- 4 对于英语以外的语种支持也得到了大大的优化。

许多现有的机器学习基准测试都是用英语编写的。为了初步了解 GPT- 4 在其他语言上的能力,OpenAI 使用 Azure Translate,将一套涵盖 57 个主题的 1.4 万多项选择题的 MMLU 基准,翻译成了多种语言,然后进行测试。

在测试的 26 种语言中,有 24 种语言,GPT- 4 优于 GPT-3.5 和其他大语言模型的英语语言性能。

其中中文达到了 80.1% 的准确性,而 GPT-3.5 的英文的准确性为 70.1%,也就是说,在这个测试中,GPT- 4 对于中文的语言理解,已经优于此前 ChatGPT 对于英文的理解。

Live Demo:报税、写诗、写代码,无所不能

如果说着这些数据、案例,似乎还难以让人直观感受到 GPT- 4 的真正实力,那么 OpenAI 的总裁和联合创始人 Greg Brockman,就亲自在 YouTube 上进行了一把直播,来实时演示 Live Demo 中,展示了 GPT- 4 的真正实力——总结文章、写代码、报税、写诗……GPT-3.5 做不到的,GPT- 4 轻松拿下。

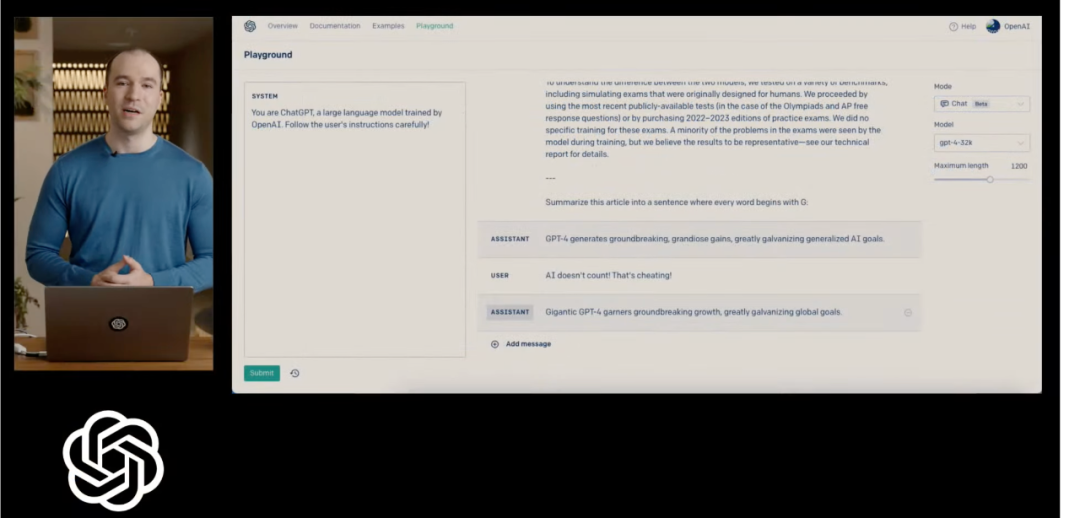

Greg Brockman 展示了 GPT- 4 的新的使用界面,左侧是系统框,可以规定 AI 的角色,以及整体的回答原则,中间则是对话框,可以输入具体的对话形态来对具体的内容进行调整、追问或者给出反馈。最右侧是一些参数设置。

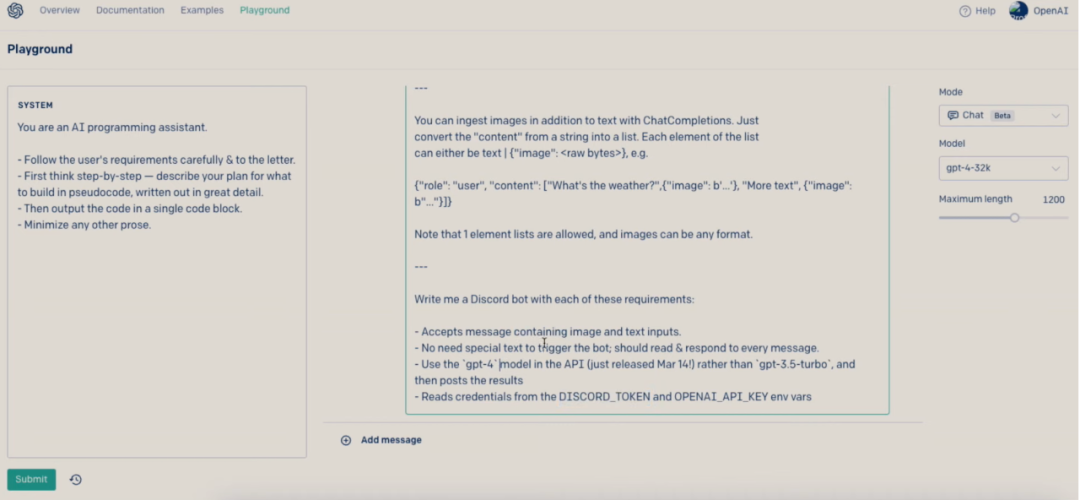

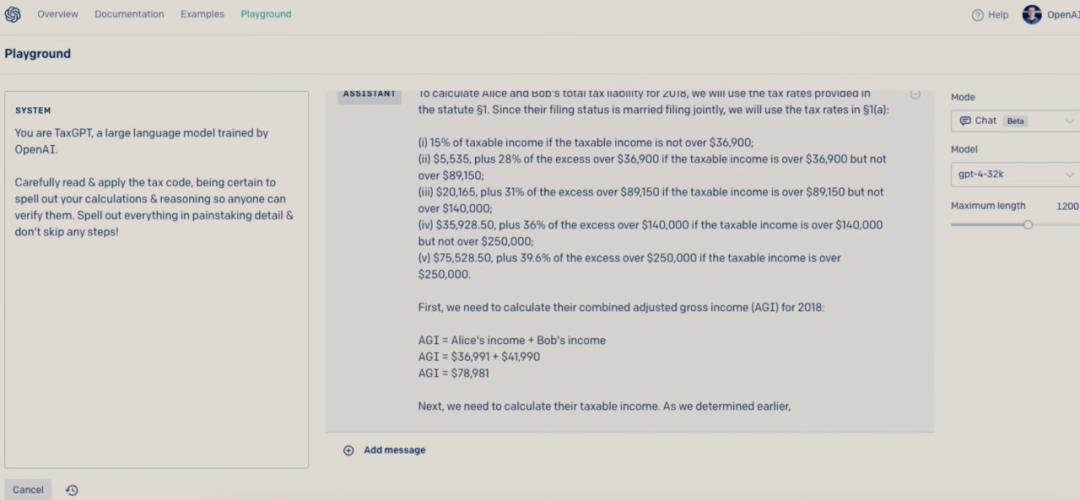

在演示中,Brockman 就使用使用左侧的“系统”框,让 GPT- 4 相继成为“ChatGPT”、“AI 编程助手”、“TaxGPT”,来解决不同的问题。

ChatGPT 模式下,GPT- 4 可以处理超过 2.5 万字的文本,可以轻松地总结一篇超长文章的核心内容,比如把 OpenAI 今天发布的这篇讲述 GPT- 4 的雄文总结要点。

甚至还可以像在演示中的那样,以各种奇怪的形式来提炼它——比如,以全是“G 字母开头”的单词来总结。

或者要它把这些内容要点写成一首诗。

在“AI 编程助手”模式下,还可以让它轻松写代码,生成一个网站,或者更复杂的,写一个基于 Discord 的机器人,如果出现错误,比如要调用比较新的 API 而出错,甚至也不需要向它解释,而是把错误代码复制进去,它就会自动纠错,生成新的代码。

或者要它变身成 TaxGPT,要它基于税务法则,来计算出一对夫妻要缴纳多少税,而且还要把计算理由一步步写出来,让人们可以检阅。

对于 GPT- 4 展示出的专业能力,Greg Brockman 大为赞赏,他表示那段税务文件,他自己读了半个小时也没有搞懂,然而 GPT- 4 却可以很快给出答案。

或许这段不到一个小时的演示,才真正道出了 GPT- 4 的强大之处——它不再仅仅是普通用户的“聊天机器人”,而将成为开发者手中的利器,在文本、编程、税务以及更多可以想见的领域,成为强大工具的开发基石。

从这一点来说,它比 ChatGPT 带来的影响,将更加广泛。

满嘴跑火车:还在跑,但是好一点

不得不提的是,尽管功能强大,但 GPT-4 与早期的 GPT 模型具有相似的局限性。最重要的是,它仍然不完全可靠——它仍然会大胆自信地编造事实,并且会出现推理错误。OpenAI 强调,仍然推荐在使用它的时候要附加诸如人工审查、或者附加上下文,甚至在高风险情境中,要避免使用它。

在 GPT- 4 公告中,OpenAI 强调该系统已经接受了六个月的安全培训,在内部对抗性真实性评估中,GPT- 4 的得分比最新的 GPT-3.5 高:“响应不允许内容的请求的可能性降低了 82%,产生真实事实的可能性提高了 40%,优于 GPT-3.5。”

这也意味着,GPT-4 相对于以前的模型来说,还是显著地减少了一本正经胡说八道的频率,而且用户千方百计提示它以让它说出被禁内容的成功率,也小了很多。

但是,这并不意味着系统不会出错或输出有害内容。例如,微软透露其 Bing 聊天机器人其实一直由 GPT- 4 提供支持,但许多用户还是能够以各种创造性的方式打破 Bing 的护栏,让机器人提供危险的建议、威胁用户和编造信息。

此外,GPT- 4 仍然是基于 2021 年 9 月之前的数据训练的,这也意味着它和前一代一样,仍然缺乏对于 2021 年 9 月之后的数据的有效理解。

“GPT-4 仍有许多已知的局限性,我们正在努力解决,例如社会偏见、幻觉和对抗性提示。”OpenAI 表示。

应用:面向开发者,越来越贵

当然,除了表现方面,还有一个明显的不同是,ChatGPT- 4 比以前的版本“更大”,这意味着它已经接受了更多数据的训练,因此运行起来也更加昂贵。OpenAI 只表示它使用了微软 Azure 来训练模型,但没有公布有关具体模型大小或用于训练它的硬件的详细信息。

这也意味使用它的成本越来越高。与 ChatGPT 不同的是,这个新模型目前还不能免费公开测试,虽然它鼓励开发者申请试用,但是将需要上等待名单。

新模型将提供给 ChatGPT 的付费用户 ChatGPT Plus(每月 20 美元),也将作为 API 的一部分提供,允许开发者付费将 AI 集成到他们的应用程序中。OpenAI 表示,多家公司已经将 GPT- 4 集成到他们的产品中,包 Duolingo、Stripe 和 Khan Academy 等。

当然,如果你不是开发者或者付费用户,但是实在是想尝尝鲜,微软的 Bing 会是最好的选择——Bing 的 AI 聊天机器人,过去六周以来,已经开始使用 GPT- 4 了。

你感觉到了吗?

* 参考资料:除去特别说明,本文图片均来自 OpenAI 官网和演示视频,版权归 OpenAI 所有

注:封面图来自于 Pexels,版权属于原作者。如果不同意使用,请尽快联系我们,我们会立即删除。

原文链接:https://tech.ifeng.com/c/8OAGGsyXUE1