原创 | 文 BFT 机器人

核心观点

ChatGPT 市场反应热烈,国内外巨头纷纷入场

据统计,ChatGPT 日活跃用户数的增速远超 Instagram,1 月份平均每天有超过 1300 万名独立访问者使用 ChatGPT,是去年 12 月份的两倍多;国内外科技巨头都非常重视 ChatGPT 引发的科技浪潮,积极布局生成式 AI,国内厂商百度、腾讯等也高度关注 ChatGPT 积极探索前沿技术,相关深度应用也即将推出。

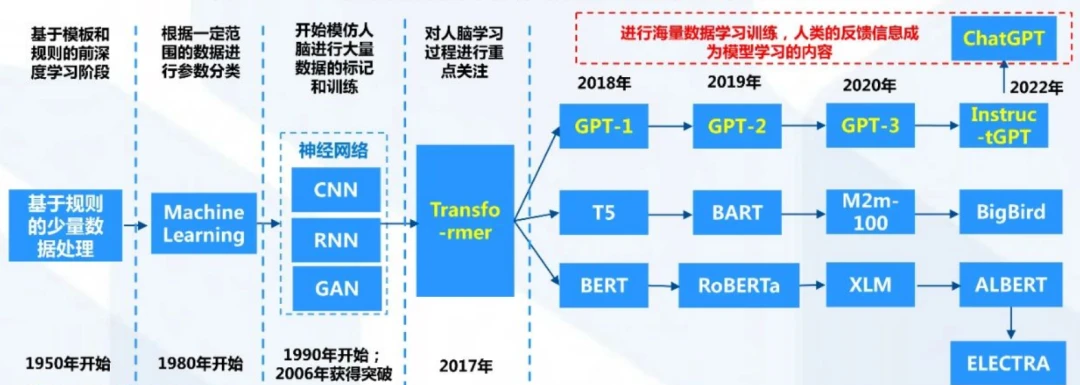

ChatGPT 经历多类技术路线演化,逐步成熟与完善

ChatGPT 所能实现的人类意图,来自机器学习、神经网络以及 Transformer 模型的多种技术模型积累。Transformer 建模方法成款以后,使用一套统一的工具来开发各种模态的基础模型这种理念得以成熟,随后 GPT-1、GPT-2、GPT- 3 模型持续演化升级,最终孵化出 ChatGPT 文本对话应用。

AIGC 跨模态产业生态逐步成熟,商用落地未来可期

AIGC 产业生态当前在文本、音频、视频等多模态交互功能上持续演化升级,奠定了多场景的商用基础。跨模态生成技术也有望成为真正实现认知和决策智能的转折点。

ChatGPT 乘东风,商业架构日益清晰

随着 ChatGPT Plus 发布,商业化序幕已经拉开。ChatGPT 在传媒,影视、营销,娱乐以及数实共生助力产业升级等领域均可产生极大助益,提升生产力曲线,多维度赋能虚拟经济和实体经济。

01

市场概况:ChatGPT-AI 平民化的里程碑

OpenAI 在成立之初便备受资本瞩目,与微软合作加速商业化进程

ChatGPT 是由 OpenAl 团队研发创造,OpenAl 是由创业家埃隆马斯克、美国创业孵化器 Y Combinator 总裁阿尔特曼、全球在线支付平台 PayPa 联合创始人彼得·蒂尔等人于 2015 年在旧金山创立的一家非盈利的 AI 研究公司,拥有多位硅谷重量级人物的资金支持,启动资金高达 10 亿美金;OpenAl 的创立目标是与其它机构合作进行 A 的相关研究,并开放研究成果以促进 A 技术的发展。

OpenAI 的 ChatGPT 是生成式人工智能技术 (AIGC) 浪潮的一部分

ChatGPT 是在 GPT 基础上进一步开发的自然语言处理模型

GPT 模型是一种自然语言处理 (NLP) 模型,使用多层变换器 (Transformer) 来预测下一个单词的概率分布,通过训练在大型文本语料库上学习到的语言模式来生成自然语言文本。从 GPT- 1 到 GPT-3 智能化程度不断提升,ChatGPT 的到来也是 GPT-4 正式推出之前的序章。

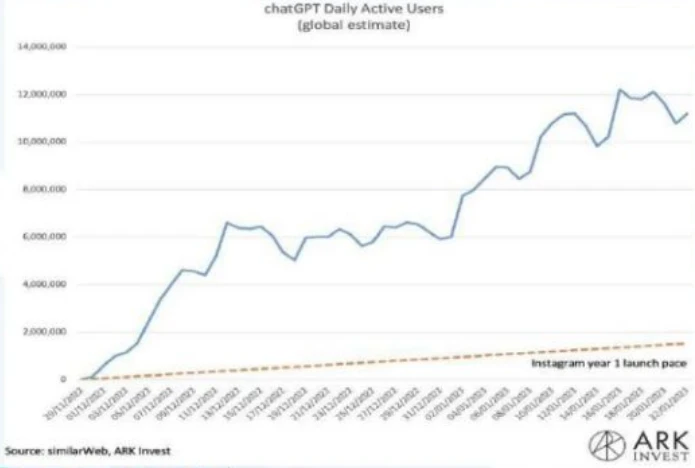

ChatGPT 发布后用户数持续暴涨, 市场影响力迅速提升

根据 UBS 发布的研究报告显示,ChatGPT 在 1 月份的月活跃用户数已达 1 亿,成为史上用户数增长最快的消费者应用相比之下,TikTok 花了九个月的时间月活跃用户数才破亿,而 Instagram 则花费了两年半的时间,同时,根据 Similar Web 的披露信息,Spotif 在四年半后仅积累了 1 亿月活跃用户。

根据 Similar Web 的数据,1 月份平均每天有超过 1300 万名独立访问者使用 chatGPT,是去年 12 月份的两倍多。

对比各大热门平台月活跃用户数破亿所需时长,ChatGPT 的成长速度惊人

ChatGPT 已能覆盖较多能力域

由于 ChatGPT 包含了更多主题的数据,能够处理更多小众主题。ChatGPT 能力范围可以覆盖回答问题、撰写文章、文本摘要、语言翻译和生成计算机代码等任务。

ChatGPT 具备诸多先进性特征

ChatGPT 嵌入了人类反馈强化学习以及人工监督微调,因而具备了理解上下文、连贯性等诸多先进特征,解锁了海量应用场景当前,ChatGPT 所利用的数据集只截止到 2021 年。

在对话中,ChatGPT 会主动记忆先前的对话内容信息(上下文理解),用来辅助假设性的问题的回复,因而 ChatGPT 也可实现连续对话,提升了交互模式下的用户体验,同时,ChatGPT 也会屏藏敏感信息,对于不能回答的内容也能给予相关建议。

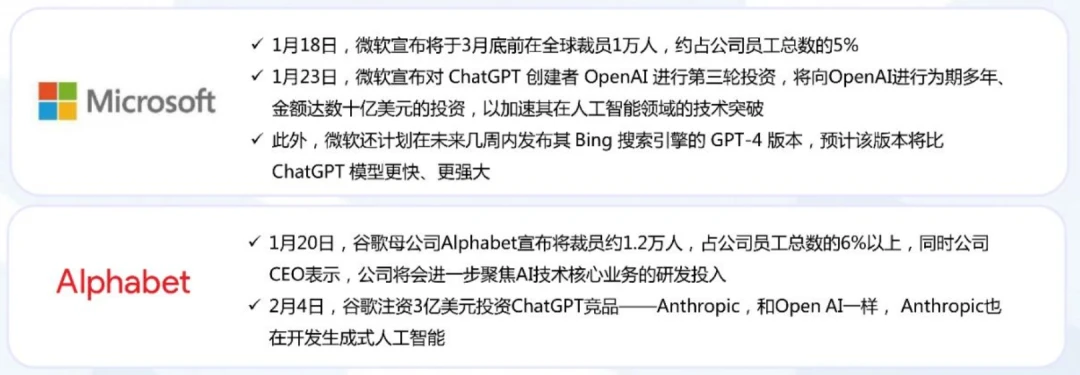

科技巨头不断下注 AI 行业,chatGPT 带动新一轮 AI 发展浪潮

2023 年初,微软和谷歌均宣布裁员计划,但都加大了在 AI 行业的投入。

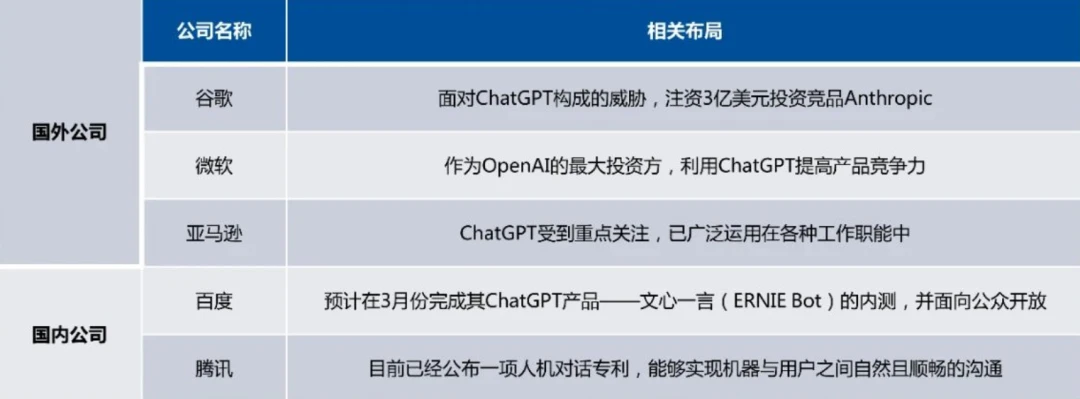

国内外科技巨头积极布局生成式 AI,部分公司已有成型产品

国内外科技巨头都非常重视 chatGPT 引发的科技浪潮,积极布局生成式 AI。

谷歌:面对 ChatGPT 构成的威胁,注资 3 亿美元投资竟品 Anthropic

在 chatGPT 发布后,谷歌 CEO 在公司内部发布了“红色警报”Code Red),敦促团队解决 ChatGPT 对公司搜索引警业务构成的威胁,同时批准了在谷歌搜索引擎中加入 AI 聊天机器人的计划。

2 月 4 日,谷歌注资 3 亿美元投资 ChatGPT 竞品 -Anthropic,谷歌将获得约 10% 的股份,Anthropic 计划将次轮资金用于购买谷歌云计算部门的计算资源;Anthropic 开发了一款名为 Claude 的智能聊天机器人,据称可与 ChatGPT 相媲美(仍未发布)Anthropic 和 OpenAI 渊源颇深,其联合创始人曾担任 OpenAI 研究副总裁。

微软:OpenAI 的最大投资方,开始利用 ChatGPT 提高产品竞争力

微软将 ChatGPT 视为新一代技术革命,将 ChatGPT 整合进 Bing 搜索引擎、Ofice 全家桶、Azure 云服务、Teams 程序等产品中微软近期宣布推出视频会议及远程协作平台的高级付费版 Microsoft Teams Premium,订阅者可享用 OpenAIGPT 提供支持的大型语言模型技术,用 AI 自动生成会议笔记,此举或对 Zoom、谷歌会议等平台形成巨大冲击

亚马逊:ChatGPT 受到重点关注,已广泛运用在各种工作职能中

ChatGPT 已经被亚马逊用于各种不同的工作职能中,包括回答面试问题、编写软件代码和创建培训文档等公司内部员工在 SIack 表示,亚马逊 Amazon Web Services(AWS)部门已经成立了一个小型工作组,以更好地了解人工智能对其业务的影响。

美国新媒体巨头 Buzzfeed 踩准 ChatGPT 风口,两天内股价飙升 3 倍

1 月 29 日,美国新媒体巨头 Buzzeed 宣布计划采用 ChatGPT 协助内容创作,其股价一夜间暴涨近 120%,两天内飙升逾 300% 成交量突破 4.38 亿股(其月平均成交量不足 2500 万股)。消息公布后同类型公司股票成交量也迎来历史高峰:C3.ai 本月成交量超过 7200 万股,为自去年 6 月以来最多语音 A 软件公司 SoundHoundAl 的成交量约为 6450 万股,几乎是其月平均值的三倍。

Stability Al : Stable Diffusion 大热,Open AI 在图片生成 AI 大有可为

Stability Al 有着与 0pen Al 相同的创业理念:构建开源 A 项目,促进 A 发展,其成功证明 Open Al 在图片生成领域同样大有可为。公司的开源模型 Stable Diffusion 可以根据文字生成图片,只需要几秒钟,就可以生成分率、清晰度高,同时不失真实性和艺术性的图片。

Jasper:采用同类底层技术,进一步证明 ChatGPT 的巨大商业潜力 Jasper

文案自动生成平台 Jasper,其技术底层是 OpenAl 的 GPT-3,在成立仅 18 个月后就达到了 15 亿美元的高估值√IBM、Autodesk 等巨头公司均是 Jasper 的付费用户,足以证明 ChatGPT 底层技术具备巨大的商业潜力。ChatGPT 出现后,其技术领先性和受欢迎程度对 Jasper 形成了强烈冲击。

国内厂商(百度 & 腾讯):高度关注 ChatGPT,积极探索前沿技术

百度:

1 月 10 日,百度宣布将升级百度搜索的“生成式搜索”能力,智能解答用户的搜索提问;2 月 7 日,百度宣布将在 3 月份完成其 ChatGPT 产品的内测,面向公众开放,该项目名字为文心一言(ERNIE Bot)。

百度指出,生成式 AI 和搜索引警是互补关系而不是替代;据路透社报道,百度计划于 3 月将类似 ChatGPT 的 AI 对话服务作为独立应用推出之后再逐步将其合并到搜索引擎中。

腾讯:

2 月 3 日,腾讯公布一项人机对话专利,能够实现机器与用户之间自然且顺畅的沟通。

AIGC 创业公司大比拼,国外 ChatGPT 的优势遥遥领先并有望延续

AI 需要大量资金、人力投入和数据积累,国内市场中巨头更具优势

人工智能不仅需要巨大的投入,还需要庞大的用户数据基础,只有互联网巨头才有这个能力产出伟大的产品。

国外是微软、谷歌、亚马逊,而国内则是百度、腾讯等互联网巨头最具潜力; 相比国外巨头,国内巨头正投入大量资金和人力成本快速发展人工智能技术,在没有硝烟的人工智能竞赛中,中国企业也将异军突起。

02

技术路径:基于人类反馈系统 ChatGPT 助力跨模态 AI 生成应用

ChatGPT 经历多类技术路线演化,逐步成熟与完善

ChatGPT 所能实现的人类意图,来自于机器学习、神经网络以及 Transformer 模型的多种技术模型积累。

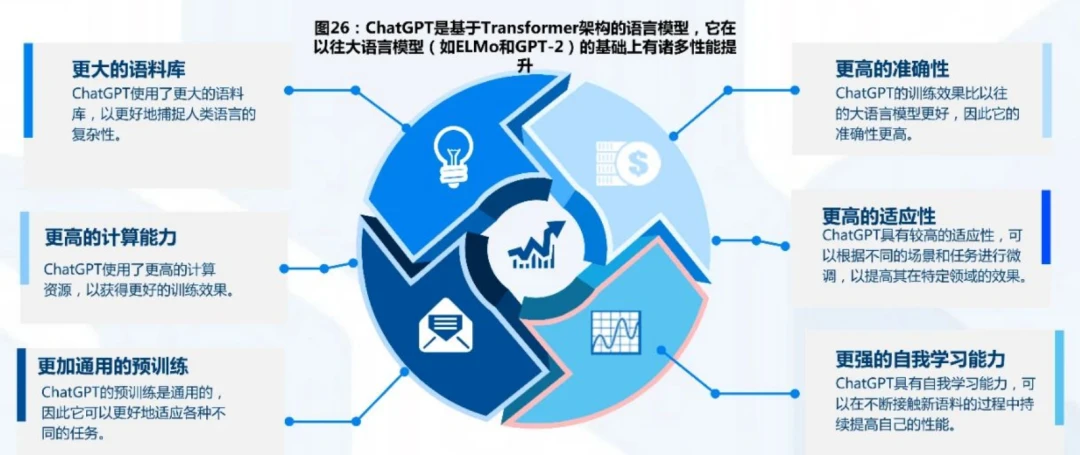

ChatGPT 模型在以往模型的基础上有了多方面的显著提升

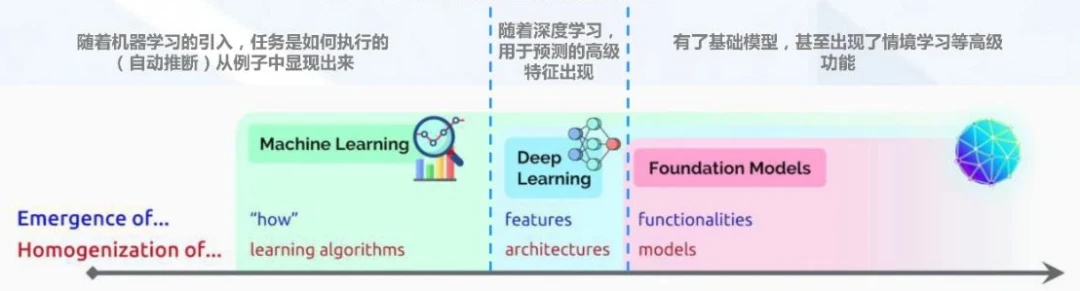

Transformer 的应用标志着基础模型时代的开始

转移学习 (Transfer Learning) 使基础模型成为可能

技术层面上,基础模型通过转移学习 (TransferLearning)(Thrun 1998) 和规模 (scale) 得以实现。转移学习的思想是将从一项任务中学习到的“知识”(例如,图像中的对象识别)应用于另一项任务(例如,视频中的活动识别)。

在深度学习中,预训练又是转移学习的主要方法: 在替代务上训练模型 (通常只是达到目的的一种手段),然后通过微调来适应感兴趣的下游任务。转移学习(Transfer Learning) 使基础模型成为可能。

大规模化 (scale) 使基础模型更强大,因而 GPT 模型得以形成

大规模需要三个要素:

-

计算机硬件的改进例如,GPU 吞吐量和内存在过去四年中增加了 10 倍;

-

Transformer 模型架构的开发(Vaswaniet al.2017),该架构利用硬件的并行性来训练比以前更具表现力的模型;

-

以及更多训练数据的可用性。

基于 Transformer 的序列建模方法现在应用于文本、图像、语音、表格数据、蛋白质序列、有机分子和强化学习等,这些例子的逐步形成使得使用一套统一的工具来开发各种模态的基础模型这种理念得以成熟。

例如,GPT-3(Brown et al.2020)与 GPT- 2 的 15 亿参数相比 GPT- 3 具有 1750 亿个参数,允许上下文学习,在上下文学习中,只需向下游任务提供提示(任务的自然语言描述),语言模型就可以适应下游任务,这是产生的一种新兴属性。

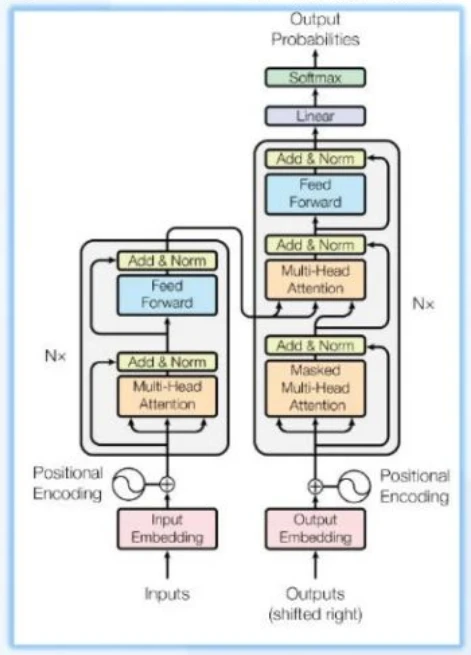

Transformer 奠定了生成式 AI 领域的游戏规则

Transformer 摆脱了人工标注数据集的缺陷,模型在质量上更优更易于并行化,所需训练时间明显更少。Transformer 通过成功地将其应用于具有大量和有限训练数据的分析,可以很好地推广到其他任务。

2017 年在 Ashish Vaswanietal 的论文《AttentionIs All You Need》中,考虑到主导序列转导模型基于编码器 - 解码器配置中的复杂递归或卷积神经网络,性能最好的模型被证明还是通过注意力机制 (attentionmechanism) 连接编码器和解码器,因而《AttentionIs AllYou Need)中提出了一种新的简单架构——Transformer,它完全基于注意力机制完全不用重复和卷积,因而这些模型在质量上更优,同时更易于并行化,并且需要的训练时间明显更少。

Transformer 出现以后,迅速取代了 RNN 系列变种,跻身主流模型架构基础。(RNN 缺陷正在于流水线式的顺序计算)

Transformer 实现的不同技术场景对应的不同技术原理

Transformer 架构可分为自回归系列(例如 GPT-3,偏好生成性任务)、双向 Transformer+Mask 的自编码系列(例如 BERT 偏好自然语言理解)、Encoder-decoder 架构(例如 T5,使用双向 / 单向 attention,偏好条件文本生成)

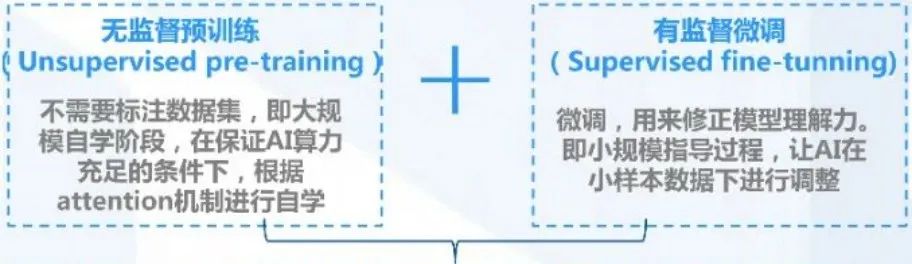

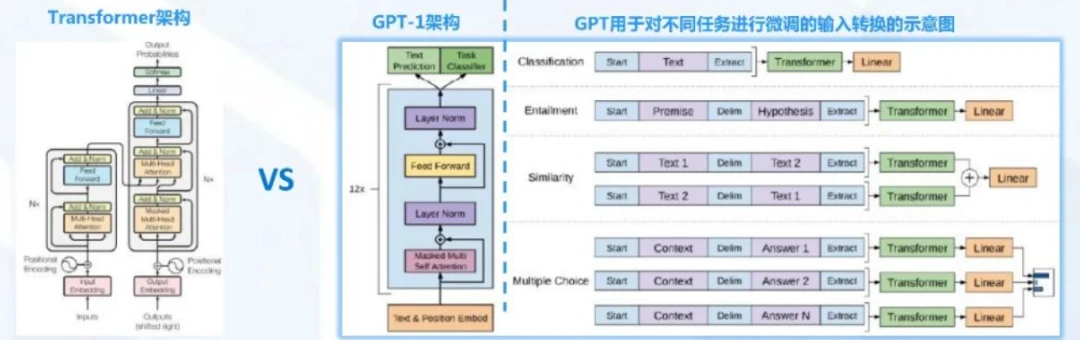

GPT-1:借助预训练,进行无监督训练和有监督微调

GPT- 1 模型基于 Transformer 解除了顺序关联和依赖性的前提,采用生成式模型方式,重点考虑了从原始文本中有效学习的能力,这对于减轻自然语言处理 (NLP) 中对监督学习的依赖至关重要。

GPT(Generative Pre-trainingTransformer)于 2018 年 6 月由 OpenAl 首次提出 GPT 模型考虑到在自然语言理解中有大量不同的任务,尽管大量的末标记文本语料库非常丰富,但用于学习这些特定任务的标记数据却很少,这使得经过区分训练的模型很难充分执行。同时,大多数深度学习方法需要大量手动标记的数据,这限制了它们在许多缺少注释资源的领域的适用性。

在考虑以上局限性的前提下,GPT 论文中证明,通过对未标记文本的不同语料库进行语言模型的生成性预训练,然后对每个特定任务进行区分性微调,可以实现这些任务上的巨大收益。和之前方法不同,GPT 在微调期间使用任务感知输入转换,以实现有效的传输,同时对模型架构的更改最小。

GPT-1:模型更简化、计算加速,更适合自然语言生成任务(NLG)

GPT 相比于 Transformer 等模型进行了显著简化。

相比于 Transformer,GPT 训练了一个 12 层仅 decoder 的解码器(原 Transformer 模型中包含 Encoder 和 Decoder 两部分)。

相于 Gooale 的 BERT(BidirectionalEncoder Representations from Transformers, 双编码生成 Transformer),GPT 仅采用上交预测单词(BERT 采用了基于上下文双向的预测手段)。

GPT- 2 在 GPT- 1 的基础上进行诸多改进,实现执行任务多样性,开始学习在不需要明确监督的情况下执行数量惊人的任务在 GPT- 2 阶段,OpenAI 去掉了 GPT- 1 阶段的有监督微调(fine-tuning),成为无监督模型。

大模型 GPT- 2 是一个 15B 参数的 Transformer,在其相关论文中它在 8 个测试语言建模数据集中的 7 个数据集上实现了当时最先进的结果模型中,Transfomer 堆叠至 48 层。GPT- 2 的数据集增加到 8 million 的网页、大小 40GB 的文本。

GPT- 2 仍未解决应用中的诸多瓶颈

GPT- 2 聚焦在无监督、zero-shot(零次学习)上,然而 GPT- 2 训练结果也有不达预期之处,所存在的问题也待优化。

在 GPT- 2 阶段,尽管体系结构是任务无关的,但仍然需要任务特定的数据集和任务特定的微调: 要在所需任务上实现强大的性能,通常需要对特定于该任务的数千到数十万个示例的数据集进行微调。

GPT- 3 取得突破性进展,任务结果难以与人类作品区分开来

GPT- 3 对 GPT- 2 追求无监督与零次学习的特征进行了改进,GPT- 3 利用了过滤前 45TB 的压缩文本,在诸多 NLP 数据集中实现了强大性能。

GPT- 3 是一个具有 1750 亿个参数的自回归语言模型,比之前的任何非稀疏语言模型多 10 倍对于所有任务(在 few-shot 设置下测试其性能),GPT- 3 都是在没有任何梯度更新或微调的情况下应用的,仅通过与模型的文本交互来指定任务和 few-shot 演示。

GPT- 3 在许多 NLP 数据集上都有很强的性能(包括翻译、问题解答和完形填空务),以及一些需要动态推理或领域适应的任务(如解译单词、在句子中使用一个新单词或执行三位数算术)。GPT- 3 可以生成新闻文章样本(已很难将其与人类撰写的文章区分开来。

InstructGPT 模型在 GPT- 3 基础上进一步强化

InstructGPT 使用来自人类反馈的强化学习方案 RLHF (reinforcement learning from human feedback)通过对大语言模型进行微调,从而能够在参数减少的情况下,实现优于 GPT- 3 的功能。

InstructGPT 提出的背景:使语言模型更大并不意味着它们能够更好地遵循用户的意图,例如大型语言模型可以生成不真实、有毒或对用户毫无帮助的输出,即这些模型与其用户不一致。另外,GPT- 3 虽然选择了少样本学习 (few-shot) 和继续坚持了 GPT- 2 的无监督学习,但基于 few-shot 的效果,其稍逊于监督微调 (fine-tuning) 的方式。

基于以上背景,OpenAI 在 GPT- 3 基础上根据人类反馈的强化学习方案 RHLF,训练出奖励模型 (reward model) 去训练学习模型(即: 用 AI 训练 AI 的思路)。

InstructGPT 的训练步为:对 GPT- 3 监督微调一训练奖励模型(reward model)- 增强学习优化 SFT(第二、第三步可以选代循环多次)

ChatGPT 核心技术优势:提升了理解人类思维的准确性

InstructGPT 与 chatGPT 属于相同代际的模型,ChatGPT 只是在 instructGPT 的基础上增加了 Chat 属性,且开放了公众测试

ChatGPT 提升了理解人类思维的准确性的原因在于利用了基于人类反馈数据的系统进行模型训练

ChatGPT 得益于通用 (基础) 模型所构建 AI 系统的新范式

基础模型(Foundation Model) 在广泛的应用中整合构建机器学习系统的方法,它为许多任务提供了强大的杠杆作用。

" 基础模型是在深度神经网络和自我监督学习的基础上演化而来。基础模型基于广泛数据 (通常使用大规模自我监督) 训练的任何模型,可以适应 (例微调) 广泛的下游任务,目前例子包括 BERT(Devlin et al.)GPT-3 (Brown et al.2020)和 CLIP (Radford et al.2021)。机器学习使学习算法同质化(例如,逻辑回归),深度学习使模型架构同质化(如卷积神经网络),而基础模型使模型本身同质化(比如 GPT-3)。

ChatGPT 以基础模型为杠杆,可适用多类下游任务

ChatGPT 采用了 GPT3.5 (lnstructGPT) 大规模预训练模型,在自然语言理解和作品生成上取得极大性能提升。

鉴于传统 NLP 技术的局限问题,基于大语言模型 (LLM) 有助于充分利用海量无标注文本预训练,从而文本大模型在较小的数据集和零数据集场景下可以有较好的理解和生成能力。基于大模型的无标准文本书收集 ChatGPT 得以在情感分析、信息钻取、理解阅读等文本场景中优势突出。

随着训练模型数据量的增加,数据种类逐步丰富,模型规模以及参数量的增加,会进一步促进模型语义理解能力以及抽象学习能力的极大提升实现 ChatGPT 的数据飞轮效应(用更多数据可以训练出更好的模型吸引更多用户,从而产生更多用户数据用于训练,形成良性循环)。

研究发现,每增加参数都带来了文本合成和 / 或下游 NLP 任务的改进有证据表明,日志丢失与许多下游任务密切相关,随着规模的增长,日志丢失呈现平稳的改善趋势。

ChatGPT 大模型架构也是 ML 发展到第三阶段的必然产物

ML 中的计算历史分为三个时代:前深度学习时代、深度学习时代和大规模时代,在大规模时代,训练高级 ML 系统的需求快速增长。

计算、数据和算法的进步是指导现代机器学习 (ML) 进步的三个基本因素。在 2010 年之前,训练计算的增长符合摩尔定律,大约每 20 个月翻一番。自 2010 年代早期深度学习 (Deep Learning) 问世以来,训练计算的规模已经加快,大约每 6 个月翻一番。2015 年末,随着司开发大规模 ML 模型,训练计算需求增加 10 至 100 倍,出现了一种新趋势一一训练高级 ML 系统的需求快速增长。2015-2016 年左右,出现了大规模模型的新趋势。这一新趋势始于 2015 年末的 AphaGo,并持续至今(GPT- 3 于 2020 年出现)。

03

行业进程:AIGC 多模态交互功能持续演化,奠定多场景商用基础

AIGC:利用人工智能产生内容,提升生产力曲线

AIGC: Artificial Intelligence Generated Context,即可以利用人工智能技术自动产生内容,常见如代码生成,文本问答等。

ChatGPT 已成为 AIGC 功能矩阵中的重要板块

ChatGPT 是 AIGC“数字内容智能编辑”功能中的重要组成部分,ChatGPT 模型的出现对于文字 / 语音模态的 AIGC 应用具有重要意义。

随着深度学习技术的快速突破以及数字内容的海量增长 AIGC 领域相关技术打破了预定义规则的局限性,使得快速便捷且智慧地输出多模态的数字内容成为可能。

在技术创新以及多模态模型的持续突破下,AIGC 根据功能和对象的不同,按顺序可包括三种主要实用功能:数字内容李生、数字内容的智能编辑、数字内容的智能创作。这三种功能相互嵌套与结合,可以让 AIGC 产品具备超越人类的创作潜力。而 ChatGPT 正是 AIGC 的数字内容智能编辑这 - 大功能领域中的重要组成部分。

AIGC 相关技术包含了三大前沿能力

数字内容李生能力构建现实世界 - 虚拟世界映射

李生能力包括智能增强与转译技术,其中增强技术弥补内容数字化过程中的信息损失,转译技术在理解基础上对内容进行多种形式呈现。

数字编辑能力打通现实世界虚拟世界交互通道

编辑能力包括智能语义理解与属性控制,语义理解帮助实现数字内容各属性的分离解翘,属性控制则在理解基础上对属性进行精确修改、编辑与二次生成,最终反馈于现实世界,形成李生 - 反馈闭环。

数字创作能力从数据理解走向数据创作

创作能力可分为基于模仿的创作与基于概念的创作,前者基于对某一类作品数据分布进行创作,而后者从海量数据中学习抽象概念,并基于概念创作出现实世界不存在的内容。

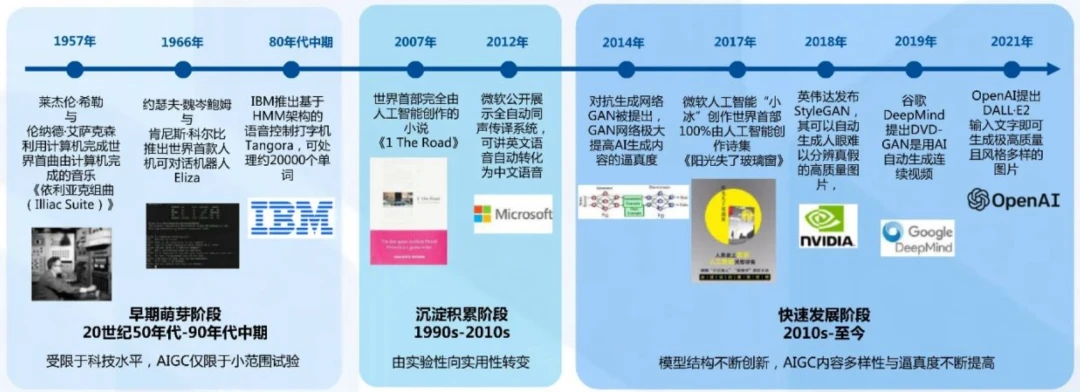

AIGC 行业发展经历了三个主要时期

AIGC 发展经历了早期萌芽、沉淀积累和 2014 年之后的快速发展阶段。

从分析式 A 到生成式 AI 逐步演化,生成式 A 赋予 AIGC 创新力

生成式 AI 起源于分析式 AI,分析式 AI 发展过程中的技术积累为生成式 AI 的产生奠定基础。

分析式 AI 其学习的知识局限于数据本身,生成式 AI 在总结归纳数据知识的基础上可生成数据中不存在的样本。最新生成式 A 技术如 GAN,Difusion 等,催生多款 AIGC 产品如:OpenAI 系列、DALLE2(Diffusion),Stary A1(基于 GAN)等。

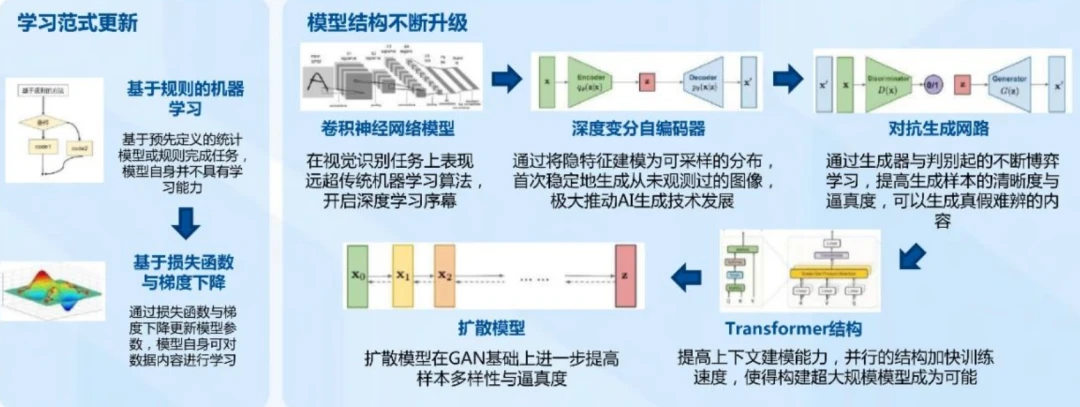

AIGC:学习范式更新奠定基础,模型结构升级助力腾飞

人工智能技术推动 AIGC 行业不断发展,其中学习范式的更新赋予 AI 模型主动学习能力,模型结构升级提升 AI 模型学习、归纳与创新能力。

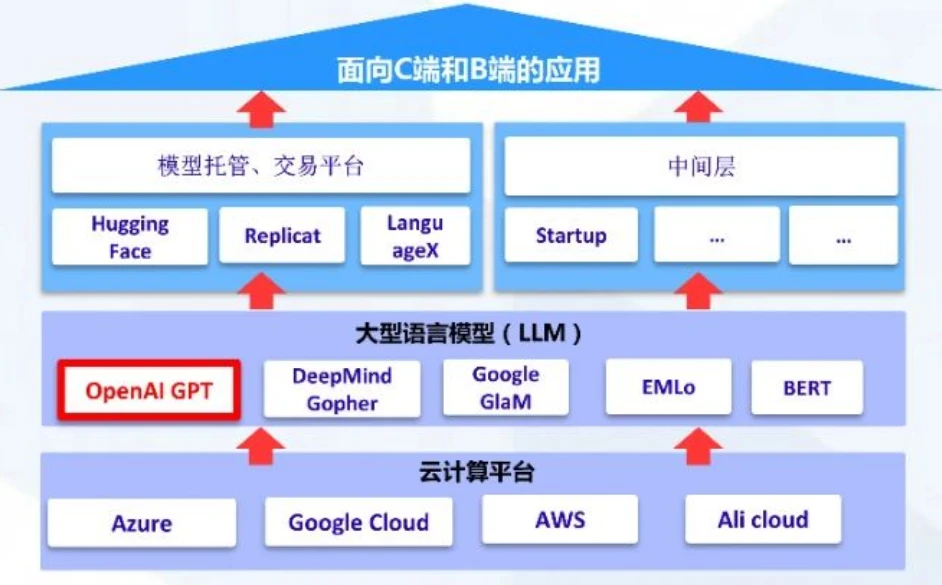

AIGC 产业链涵盖了从硬件到多类终端应用的广泛领域

AIGC 关联产业可分为应用层、模型层、云计算平台与计算硬件层

计算硬件层结合云计算平台为 AIGC 提供机器学习训练与推理算力,其中 GPU 与 TPU 为硬件核心,主要参与厂商包括英伟达 (GPU) 与谷歌(TPU);云平台参与厂商则包含 AWS,GCP,Azure 以及 Coreweave;计算硬件层中云计算平台厂商分布稳定,竞争出现于模型层面与应用层面。

模型层面,闭源基础模型提供商如 OpenAI 通过 API 向用户提供服务而开源基础模型则通过在托管平台如 Hugging Face、Replica 公开模型权重。模型训练其高计算力需求推动了模型层厂商与云计算厂商建立合作关系,如 OpenAI+Azure,GCP+DeepMind。模型层面闭源模型较为普遍,各厂商依靠模型建立技术壁垒。

AIGC 产业链上下游玩家百花齐放

AIGC 上游主要包括数据供给方、算法机构、创作者生态以及底层配合工具等,中游主要是文字、图像、音频和视频处理厂商,其中玩家众多,下游主要是各类内容创作及分发平台以及内容服务机构等。

AIGC 厂商之间的竞争在于模型层面竞争

追根溯源,AIGC 依赖于底层机器学习模型产生内容,因此模型为 AIGC 行业厂商真正竞争力所在。

文本生成产品多依赖 GPT 系列模型,自己训练的模型在图像 / 视频模态产品中较为普遍(图像 / 视频模态产品通常拥有自己训练的模型,而不是如文本模态调用 OpenAI 提供的模型服务)。比较而言,OpenAI 依靠模型建立先发竞争优势,技术到产品转化相对亮眼。

AIGC 取长补短,有望成为主流内容生产模式

AIGC 所属内容生产生态的发展经历了专家生产内容 (PGC)、用户生成内容(UGC)、A 辅助生产内容、AI 生产内容(AIGC) 四个阶段,目前处于一、二阶段为主,第三阶段为辅的境况。AIGC 克服 PGC 与 UGC 存在的 质量、产量无法兼具的缺点,其有望成为未来主流的内容生产模式。

AIGC 生成技术可按模态进行分类

AIGC 根据其内容模态不同可分为文本、视频、图像,音频与跨模态生成

AIGC 不同模态对应着各种生成技术及应用场景AIGC 不同模态对应的技术应用场景也有着各自的细分品类。

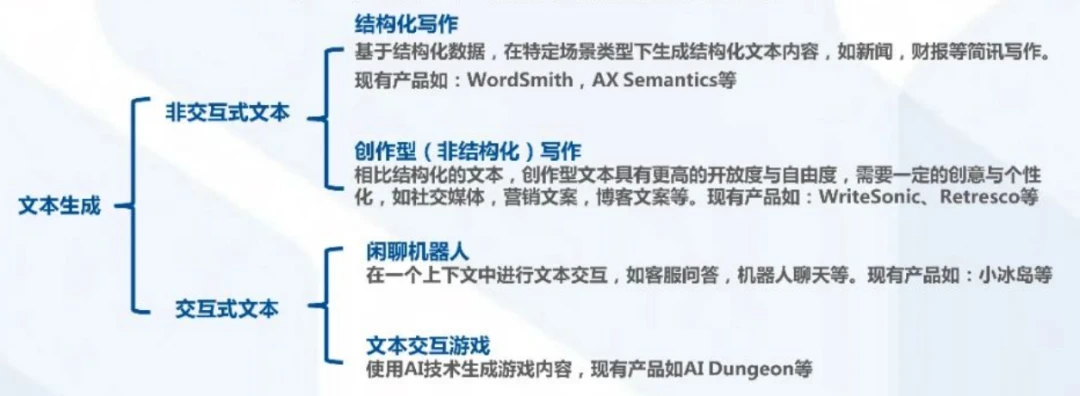

AIGC 文本生成技术场景可分为交互式和非交互式

AIGC 非交互式文本生成技术中,结构化写作其形式相对固定,生成难度较小,商业化应用较为广泛;而创作型写作开放性较大,在长文本生成中难度较大,仍需技术进一步发展。

随着通信互联网技术发展,线上社交需求快速增长,如闲聊机器人等交互式文本产品将迎来快速发展。

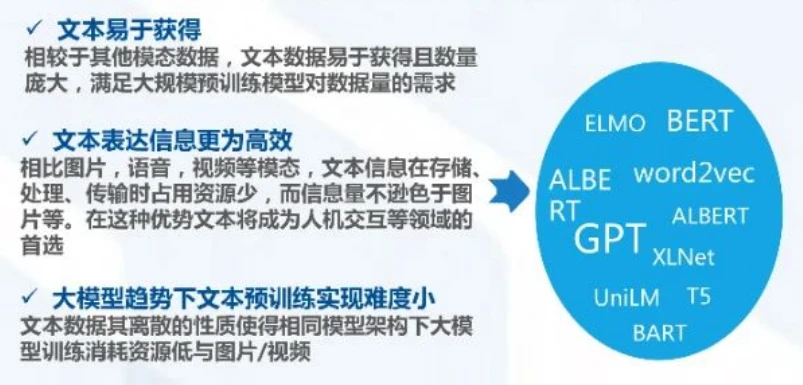

AIGC 文本生成技术商业化落地有望优势先发

文本领域预训练大模型技术成熟,文本领域细分垂类较多,产品数量居首位,模型数量发展超过其他模态技术数字内容中,文字模态数据远大于图片 / 视频 / 音频等,发展前景相对较大。

基于 GPT- 3 的文字生成功能已嵌入如 Writesonic、Conversion.ai、Copysmith 等软件中,商业化前景相对清晰。

AIGC 图像生成技术随着模型结构的优化而明显提升

模型结构不断进化提高了 AIGC 生产图像的多样性,但要求较高的功能实现还有待于技术的进一步提升。

" 图像编辑”难度低于 " 图像生成”与 "2D-3D”转换,目前已存在多款产品支持“图像编”,而对于“图像生成”任务,由于图片相较包含更多元素,其生成效果仍存在不稳定性,对于要求较高的功能类图像生成仍需要技术上的提升。

AIGC 音频生成技术正朝更富情感等人类特征演化

文本到语音任务已比较成熟,语音质量已达到自然的标准,未来将朝更富情感、富韵律的语音合成以及小样本语音学习方向发展。

音乐生成任务中仍需解决音乐数据难以标注的问题,数据标注其颗粒度大小影响音乐生成任务的可控性。若可控性得以解决,则可指定风格情绪等因素的音乐生成任务有希望在影视、游戏等场景下的到大量应用。

视频生成为 AIGC 应用生态中的高潜力场景

视频生成本质上与图片生成类似,通过对视频进行帧数级别的切割,实现对每一顿的处理。

视频生成过程包括三个阶段:数据的提取、训练和转换,当前技术正在着重提升视频修改精准度和实时性两个维度。鉴于视频本身的文本、图像和音频的综合属性,视频生成也是跨模态生成领域的重要应用场景。

跨模态生成技术是真正实现认知和决策智能的转折点

现实世界的信息是文本、音频、视觉、传感器以及人类各种触觉的综合体系,要更为精准地模拟现实世界,就需要将各种模态能力之间打通,例如文字 - 图像、文字 - 视频等跨模态生成能力。

大型预训练模型的发展使得跨模态逐步成熟," 文本 - 图像”生成正在快速落地," 文字视频”的实验效果也已较为理想(视频时长、清晰程度、逻辑等还有较大提升空间)

AIGC 改变数字内容生产模式

AIGC 作为新的内容生产模式,其具有内容多样,可控性强与生产效率高的优点,符合传媒,电商,影视,娱乐等行业对内容数字化程度高、内容多样以及内容更新快的要求,AIGC 在以上行业逐渐替代传统内容生产模式的趋势十分显著。

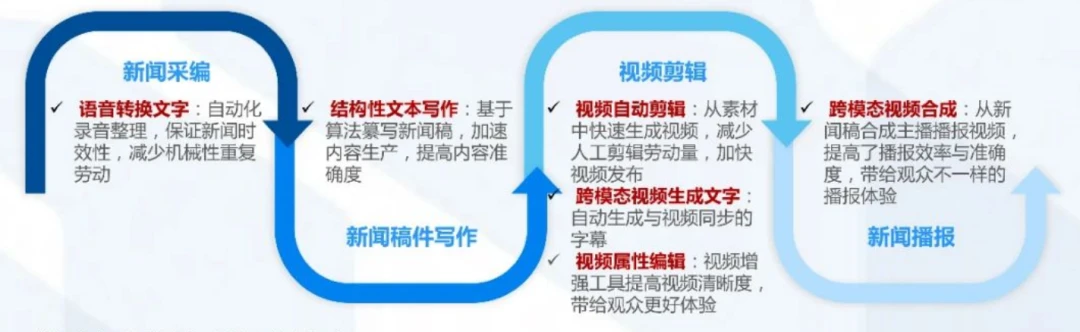

AIGC 渗透传媒领域各个环节AIGC 技术逐渐渗透传媒领域包括采集、编辑、传播等环节,有助于加快内容生产效率,提高内容质量,扩宽内容影响力。

AIGC 化 2D 为 3D,拓展电商展示维度

AIGC 2D 图像生成 3D 模型技术为传统电商提供多维度的展示空间,虚拟合成主播为客户提供更及时、可靠、亲和的服务体验。

AIGC 打破传统娱乐体验边界

AIGC 技术打破物理边界,使粉丝可与偶像亲密互动,并形成新的发展点,AIGC 为用户打开虚拟世界入口,通过趣味方式体验虚拟世界。

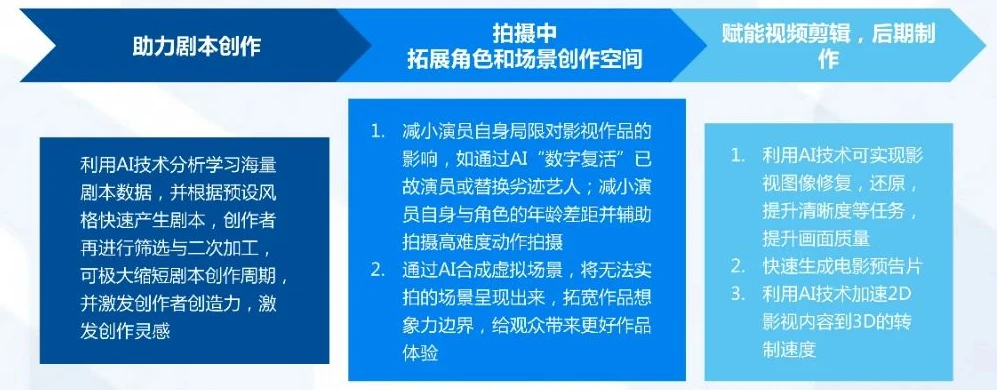

AIGC 拓宽影视行业创意边际

AIGC 技术以其内容多样性为作品内容带来更多灵感,AIGC 技术帮助拍摄突破物理限制,还原剧本效果,提高作品质量。

AIGC 促进各行业转型升级

AIGC 技术在各行业数字内容相关领域均有发挥空间。

04

商业化:多领域多功能应用密集落地,ChatGPT 商用前景可期

ChatGPT 试点订阅计划——ChatGPT Plus 发布,商业化序幕已经拉开

2023 年 2 月 2 日,OpenAI 发布 chatGPT 试点订阅计划 –ChatGPT Plus,每月 20 美元。ChatGPTPlus 订阅者可获得比免费版本更稳定、更快的服务,及尝试新功能和优化的优先权。

ChatGPT+ 传媒:实现智能新闻写作,提升新闻的时效性

ChatGPT 可以帮助新闻媒体工作者智能生成报道,将部分劳动性的采编工作自动化,更快、更准、更智能地生成内容。

ChatGPT+ 影视:拓宽创作素材术,提升作品质量

ChatGPT 可以根据大众的兴趣身定制影视内容,从而更有可能吸引大众的注意力,获得更好的收视率、票房和口碑。

ChatGPT 可以为剧本创作提供新思路,创作者可根据 ChatPT 的生成内容再进行筛选和二次加工,从而激发创作者的灵感,开拓创作思路,缩短创作周期。

ChatGPT 有着降本增效的优势,可以有效帮助影视制作团队降低在内容创作上的成本,提高内容创作的效率,在更短的时间内制作出更高质量的影视内容。

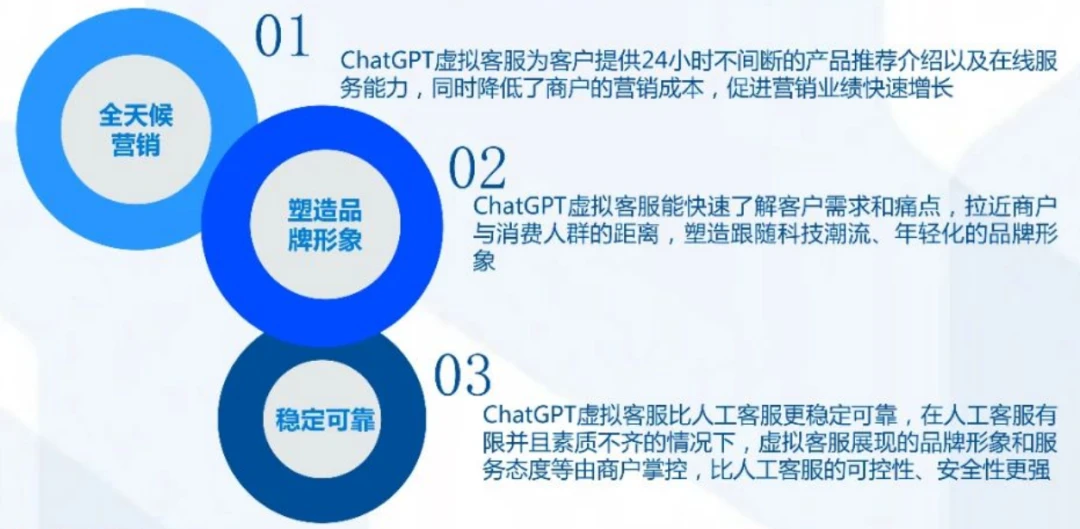

ChatGPT+ 营销: 打造虚拟客服,赋能产品销售

ChatGPT+ 娱乐:人机互动加强,激发用户参与热情

ChatGPT 可以成为线上的实时聊天对象,增加互动的趣味性和娱乐性。

ChatGPT+ 其他:促进数实共生,助力产业升级

-

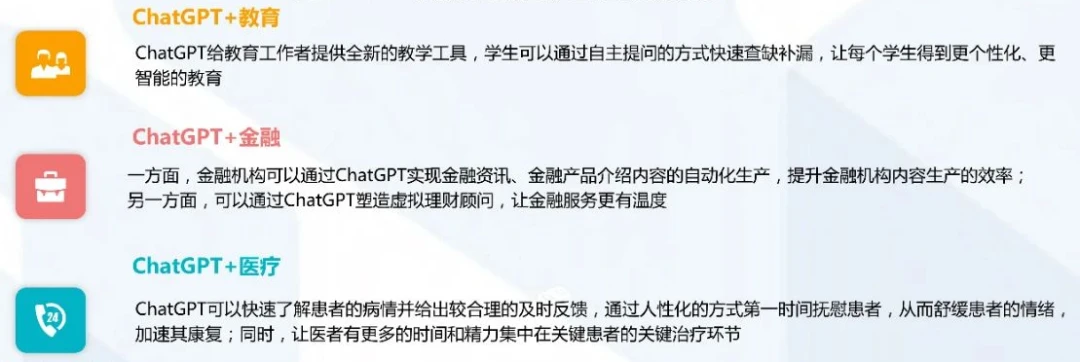

ChatGPT+ 教育:赋予教育教材新活力,让教育方式更个性化、更智能

-

ChatGPT+ 金融:帮助金融机构降本增效,让金融服务更有温度

-

chatGPT+ 医疗:赋能医疗机构诊疗全过程

短期来看,ChatGPT 的快速推广阻力仍存

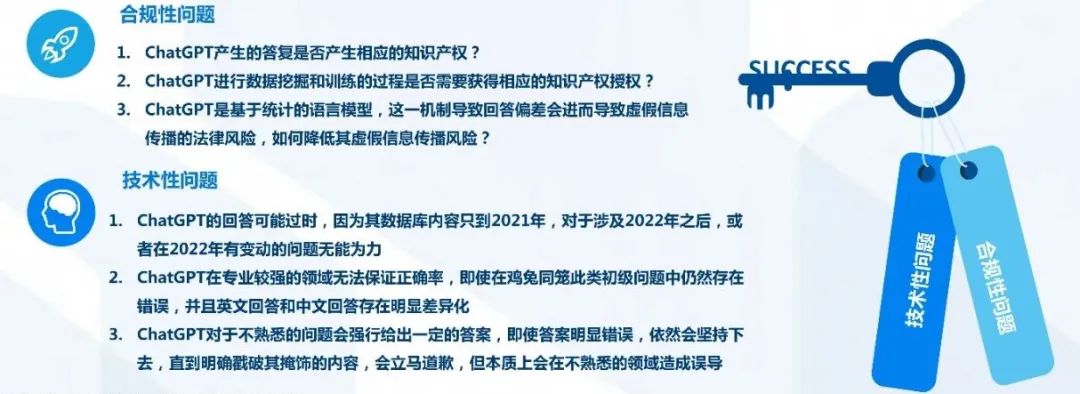

短期来看,ChatGPT 仍存在诸多不足,待解决的问题主要有两方面:合规性问题和技术性问题。

更多精彩内容请关注公众号:BFT 机器人

本文为原创文章,版权归 BFT 机器人所有,如需转载请与我们联系。若您对该文章内容有任何疑问,请与我们联系,将及时回应。

原文链接:https://www.bilibili.com/read/cv22435866