查看引用 / 信息源请点击:映维网

可以直接从文本描述中生成 3D asset

( 映维网 Nweon 2023 年 05 月 17 日 )OpenAI 在研究文本到三维对象方面取得了快速进展。已经托管至 GitHub 的 Shap- E 据称可以直接从文本描述中生成 3D asset,或者从提供的图像中构建相关内容。

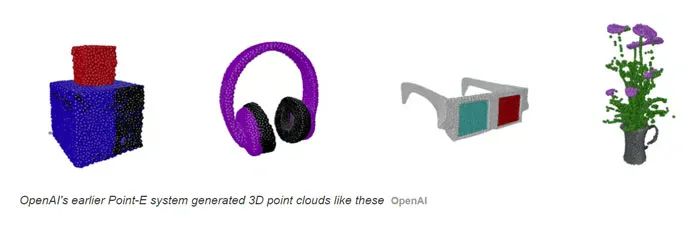

如果大家有印象,OpenAI 早在 2022 年 12 月就发布了能够根据文本提示建立点云形式的基本 3D 模型的 Point- E 系统。

现在,团队又发布了速度大大增加的全新系统 Shap-E。其中,它能够以“隐式函数“的形式建立模型,既可以呈现为纹理网格,又可以呈现为神经辐射场(NeRFs),即使用机器学习从二维图像中开发的三维模型。团队指出,尽管质量不及其他优化模型,但 Shap- E 的速度要快几个数量级,从而为用户提供了有利的权衡。

近来生成式图像模型的爆炸性增长,所以社区对训练其他类似模型的兴趣越来越大,如音频、视频和 3D asset。大多数都适合于可以直接生成的自然的、固定大小的张量表示,例如图像的像素网格或音频的样本阵列。然而,如何以一种高效生成并易于在下游应用中实现的方式来表示 3D asset 是一个问题。

最近,隐性神经表征(INRs)已成为流行的 3D asset 编码方式。为了表示三维资产,INRs 通常将 3D 坐标映射到特定的位置信息,如密度和颜色。一般来说,INRs 独立于分辨率,因为它们可以在任意的输入点进行查询,而不是在一个固定的网格或序列中进行信息编码。由于它们是端到端的可微分,INRs 能够实现各种下游应用,例如可微分的形状编辑。

在研究中,OpenAI 专注于两种类型的 INRs 的 3D 表示:

-

神经辐射场(NeRF)是一种 INR,它将 3D 场景表示为一个将坐标和观察方向映射到密度和 RGB 颜色的函数。NeRF 可以通过查询密度和沿 camera 光线的颜色,从任意视图中渲染出来,并进行训练以匹配 3D 场景的 ground truth 渲染。

-

DMTet 和它的扩展 GET3D 将一个有纹理的三维网格表示为一个将坐标映射到颜色、符号距离和顶点偏移的函数。这个 INR 能够以可微分的方式构建 3D 三角形网格,而所得到的网格可以使用可微分光栅化库进行高效渲染。

尽管 INR 灵活和富有表现力,但为数据集中的每个样本获取 INR 的过程成本可能十分高昂。另外,每个 INR 可能存在诸多数字参数,在训练下游生成模型时可能会带来挑战。

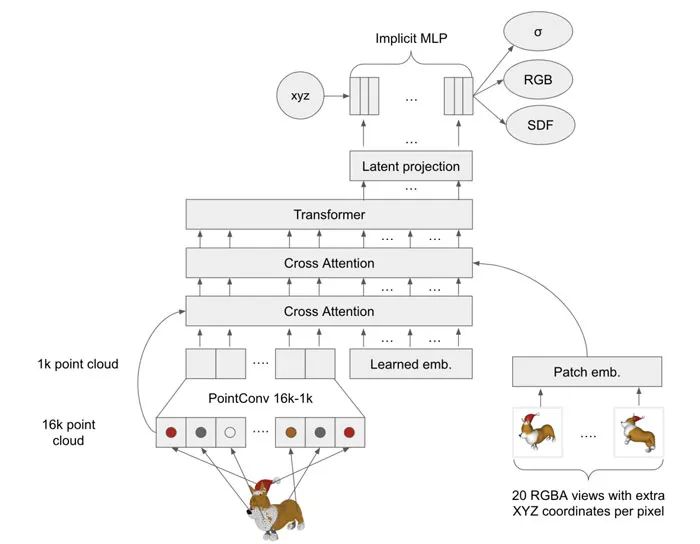

针对所述问题,社区有尝试使用带有隐式解码器的自动编码器来获得较小的 latent 表征,从而直接用现有的生成技术进行建模。另外,有人使用元学习来创建一个共享大部分参数的 INRs 数据集,然后在自由参数训练扩散模型或归一化流。其他人则进一步建议,基于梯度的元学习根本没有必要,而是可以直接训练一个 Transformer 编码器来产生以 3D 对象的多个视图为条件的 NeRF 参数。

OpenAI 结合并扩大了上述几种方法,并最终得出了 Shap-E。

这是一个适用于各种复杂的 3D latent 表征的条件生成模型。首先,团队通过训练一个基于 Transformer 的编码器来产生 3D asset 的 INR 参数。接下来,在编码器的输出上训练一个扩散模型。

与以前的方法不同,产生的 INR 同时代表 NeRFs 和网格,允许它们以多种方式渲染或导入下游的 3D 应用程序。

Shap-E

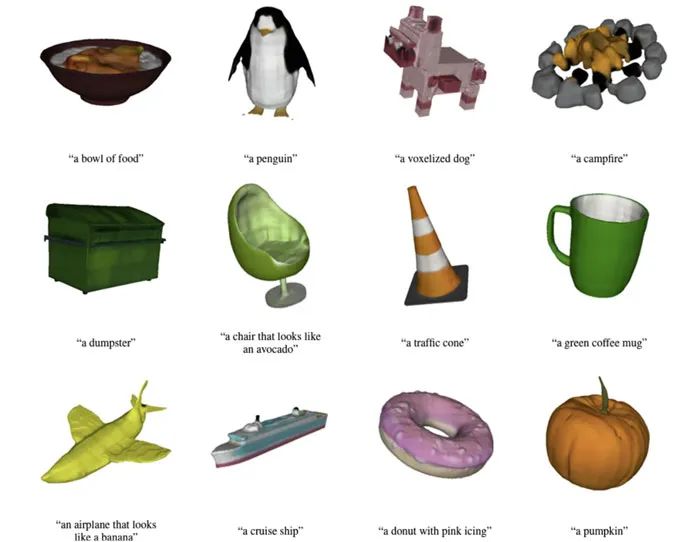

在对数百万个 3D asset 的数据集进行训练时,模型能够在文本提示的条件下产生多样化的、可识别的样本,如上图所示。

Point-E

与早前提出的显式 3D 生成式模型 Point- E 相比,这个模型收敛得更快,并且在共享相同的模型结构、数据集和调节机制的情况下,它可以获得可比或更高的结果。令人惊讶的是,Shap- E 和 Point- E 在以图像为条件时倾向于出现相同成功和失败的案例,这表明对输出表示的非常不同选择依然可以导致类似的模型行为。

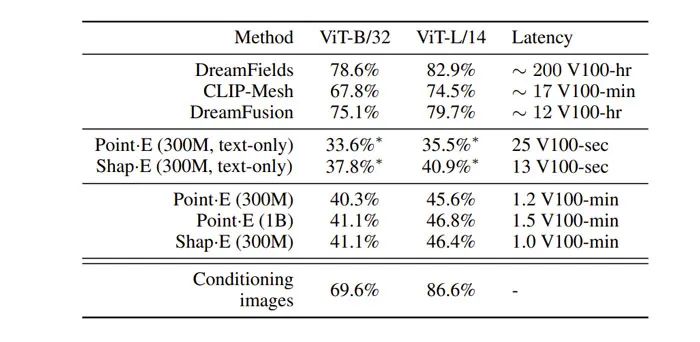

然而,研究人员同时观察到这两个模型之间的质量差异,特别是当直接以文字说明为条件时。像 Point- E 一样,Shap- E 的样本质量依然比基于优化的文本条件的 3D 生成式方法要差。然而,它在推理时间上比所述方法快了几个数量级,允许一个潜在的有利权衡。

相关论文 :Shap-E: Generating Conditional 3D Implicit Functions

例如,对于质量要求不高的场景元素,用户可以通过 Shap- E 快速生成相关的 3D asset,而对于其他元素,用户则可以使用质量更多的 3D 生成式方式,从而快速高效地完成场景创建。

—

原文链接:https://news.nweon.com/107753

原文链接:https://www.bilibili.com/read/cv23745012/