来源:投稿 作者:摩卡

编辑:学姐带你玩 AI 公众号

别骂我吹牛皮~ 不标题党你们不爱看 …….

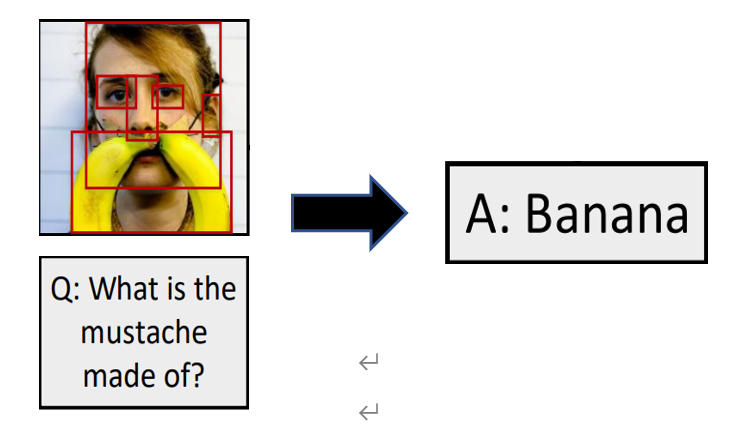

Visual Question Answering(VQA)任务

随着计算机视觉和自然语言处理技术的飞速发展,跨模态任务已经受到了两个领域的广泛关注,例如图像描述(Image Captioning)、图像检索(Image Retrieval)、视觉问答(Visual Question Answering)等任务。视觉问答任务是给定一张图片和一个与图片相关的问题,视觉问答模型来预测答案。视觉问答有很广泛的应用场景,例如早期教育、帮助盲人获取外部信息等。

图 1:VQA 任务过程

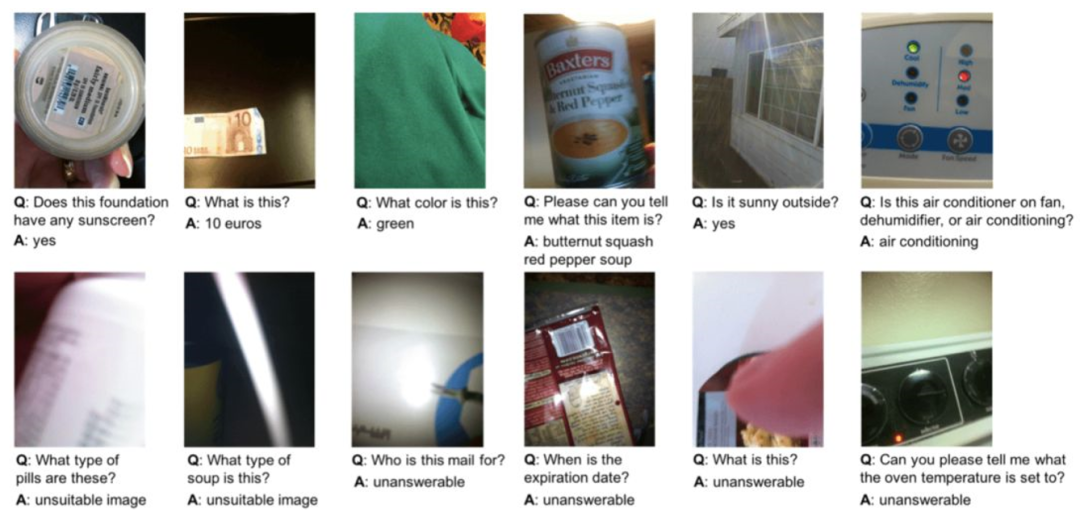

图 2:视觉助理:帮助视弱、盲人患者理解网上的图片、辨别物体、了解周围的环境等

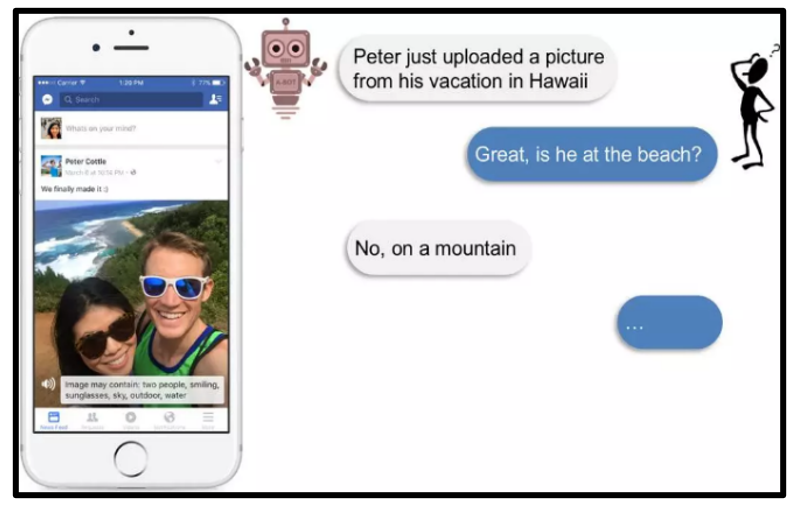

图 3:聊天机器人:可以用于 VR 程序中帮助用户与虚拟伙伴进行交流

图 4:在线教育:比如在线教育平台的虚拟老师可以根据图片回答低年级学生的一系列问题,比如“图中有几个小朋友?”,“图中有几个枕头?”。

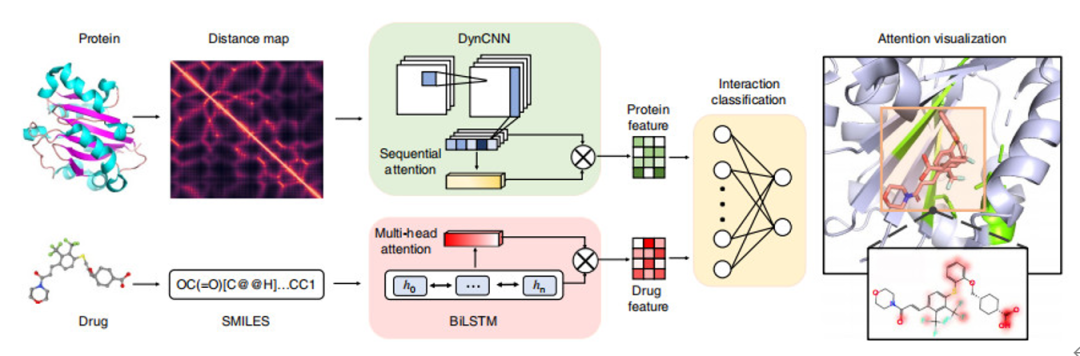

图 5:医学领域的应用

例如预测药物 - 蛋白质相互作用,给定的图片是蛋白质间的距离,问题是药物的简化分子(有专门的结构处理就像 NLP 中的 RNN)输出答案是是否会相互作用。

与其他跨模态任务相比,视觉问答是一个更具挑战性的任务,因为它需要对图像信息和文本信息有更细粒度的语意理解,并且还需要视觉推理来预测出正确答案。所以视觉问答任务中最困难的部分是如何实现对多模态输入进行全面、综合的语义对齐。

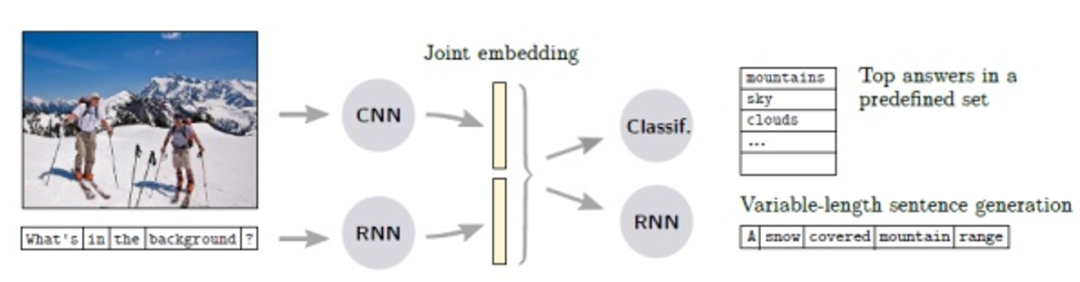

早期为解决这一问题所提出的机制是采用全局特征直接融合,然后去预测答案。基于全局特征融合的方法首先使用传统的 CNN 网络(如 VGG、ResNet、GoogleNet 等)提取出图像的全局特征,使用 RNN(LSTM、GRU 等)提取出文本的特征,然后将这两种不同的全局特征进行拼接,得到融合特征,以此来预测答案。

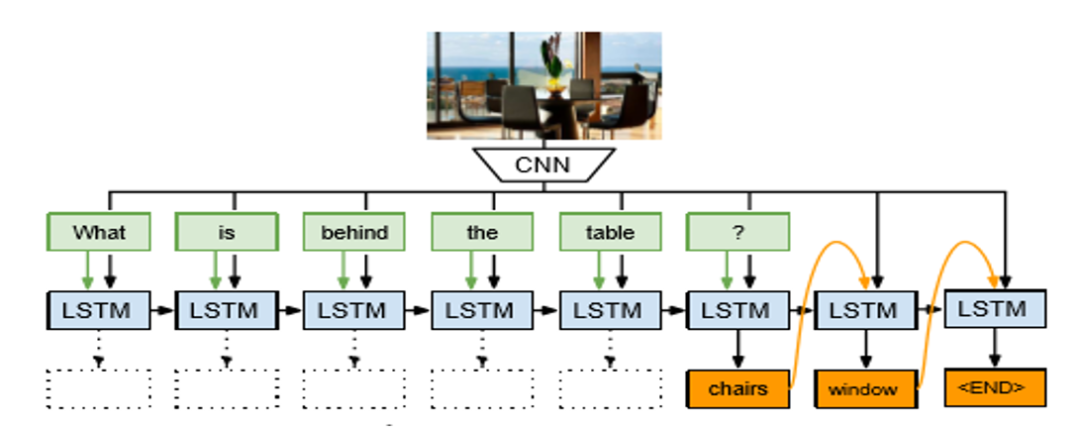

Mateusz Malinowski 等在 Ask Your Neurons: A Neural-based Approach to Answering Questions about Images 使用了该方法,首先使用 GoogleNet 提取出图像的全局特征,文本特征使用的是单词所对应的 One-hot 向量,然后将图像特征和文本特征进行拼接,得到融合特征后送入 LSTM 单元来生成正确答案。但是基于全局特征直接融合的方式取得的效果并不好。

其局限性在于图像的全局特征表示可能会丢失有关局部图像区域的关键信息,从而导致无法正确回答问题。

图 6:特征融合方法解决 VQA 任务的框架

图 7:Ask Your Neurons: A Neural-based Approach to Answering Questions about Images 模型图

近年来,随着注意力机制在自然语言处理领域的成功应用,许多学者将注意力机制运用到了视觉问答任务中。对于给定的问题,通过自适应地学习图像区域地权重,然后实现多特征融合,以此来预测正确答案。

Chen 等在 An attention based convolutional neural network for visual question answering 提出了以问题为导向地注意力机制,将问题特征嵌入到视觉空间中去,以此来预测正确答案。

Z. Yang 等在 Stacked Attention Networks for Image Question Answering 中提出了多步推理注意力机制,但是在此注意力机制中,每次推理地视觉特征都是不变地这极大的限制了模型地推理能力。

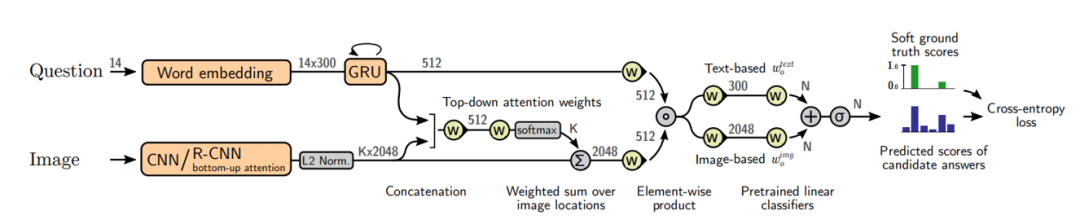

在 2018 年,Anderson 等人在 Bottom-up and top-down attention for image captioning and visual question answering 中开创性地提出了自上而下和自下而上的注意力机制来学习候选对象地特征,首先使用 Faster RCNN 提取出图像中对象的特征,接着将提取出来的视觉特征与 GRU(或 LSTM)提取出的文本特征进行融合,得到注意力权重分布矩阵,将此矩阵与 Faster RCNN 提取出的视觉特征相融合产生注意力视觉特征,最后根据注意力视觉特征和问题的文本特征进行融合预测出答案。

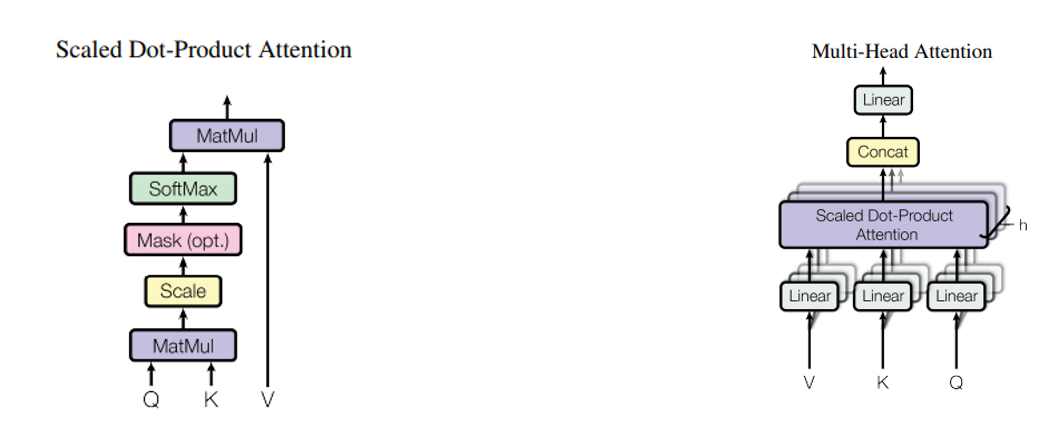

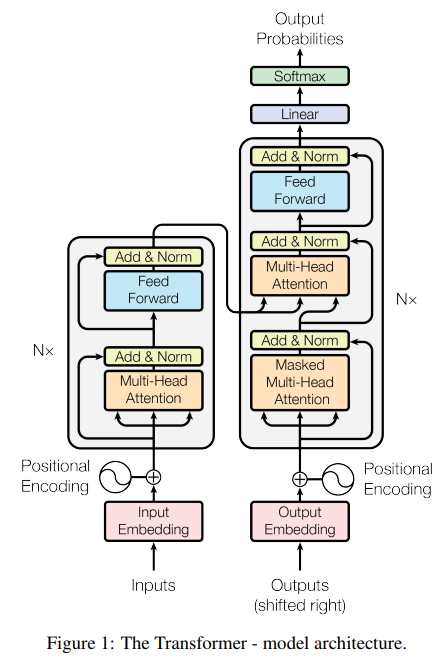

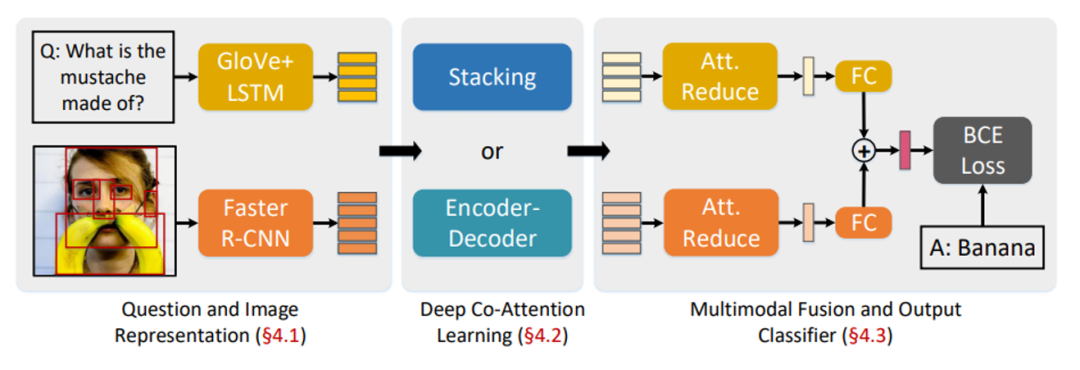

最近还有好多研究者将 Transformer 结构应用在注意力阶段,以此来融合视觉特征和问题特征如 Deep Modular Co-Attention Networks for Visual Question Answering。

图 8:Bottom-up and top-down attention for image captioning and visual question answering 模型图

图 9:Scaled Dot-Produce Attention 计算过程 图 10:Multi-head attention 机制

图 10:Transformer 结构图

图 11:Deep Modular Co-Attention Networks for Visual Question Answering 模型图

个人认为跨模态模型是人工智能模型发展的最终目的,因为人工智能的最终目的就是让机器模拟人类的行为,通过对不同模态数据 (例如:图片、文本、音频) 同时的融合,模拟人类可以分析推理复杂问题的能力,最终实现理想化的“人工智能”。

在近期的发展中多模态任务会成为一个新的蓝海,并且随着大规模预训练模型的发展以及大规模数据集的提出,相信该领域还会进一步推动人工智能领域的发展。

参考文献

[1]Zhou Yu, Jun Yu, Yuhao Cui, Dacheng Tao, Qi Tian. Deep Modular Co-Attention Networks for Visual Question Answering. In CVPR, 2019.

[2]Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, Lukasz Kaiser. Attention Is All You Need. arXiv:1706.03762v5 [cs.CL] 6 Dec 2017.

[3]Peter Anderson, Xiaodong He, Chris Buehler, Damien Teney, Mark Johnson, Stephen Gould, Lei Zhang. Bottom-Up and Top-Down Attention for Image Captioning and Visual Question Answering. In CVPR, 2018.

[4]Damien Teney, Peter Anderson, Xiaodong He, Antovan den Hengel. Tips and Tricks for Visual Question Answering: Learning from the 2017 Challenge. In CVPR, 2018.

[5]Mateusz Malinowski, Marcus Rohrbach, Mario Fritz. Ask Your Neurons: A Neural-based Approach to Answering Questions about Images. In ICCV, 2015

— 完 —

点这里👇关注我,记得标星哦~

点赞的情谊学姐铭记在心~

原文链接:https://www.bilibili.com/read/cv15170461