从 GPT- 1 到 GPT4 的技术发展过程

GPT-1:GPT-1 是 OpenAI 在 2018 年发布的第一个基于 Transformer 的预训练模型 , 采用了单向 Transformer 架构 , 包含了 12 层和 117M 个参数。GPT-1 可以用于生成文本、问答和文本分类等任务。

GPT-2:GPT-2 是 OpenAI 在 2019 年发布的升级版模型 , 采用了更多的参数和更深的 Transformer 架构 , 包含了 1.5B 个参数。GPT-2 在生成文本、问答、翻译和摘要等任务上表现出色。

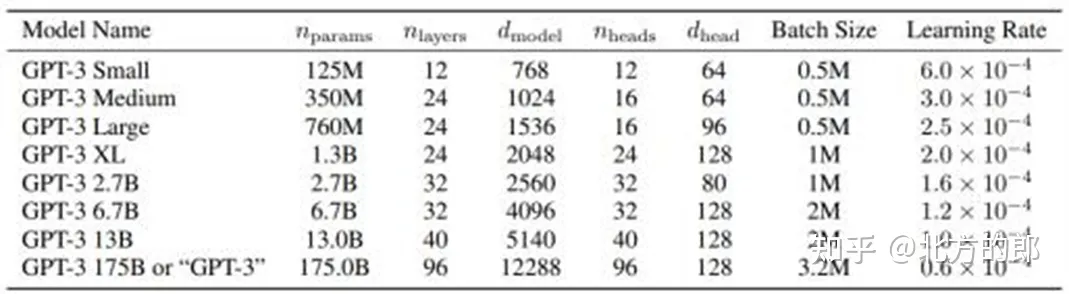

GPT-3:GPT-3 是 OpenAI 在 2020 年发布的预训练模型 , 采用了更大的规模和更多的技术创新 , 包含了 175B 个参数。GPT-3 在生成文本、问答、翻译、摘要和对话等任务上都取得了非常好的表现。

ChatGPT:ChatGPT 是 OpenAI 在 2022 年基于 GPT-3 模型的升级版 , 主要针对对话任务进行了优化 , 增加了对话历史的输入和输出 , 以及对话策略的控制。ChatGPT 在对话任务上表现出色 , 可以与人类进行自然而流畅的对话。

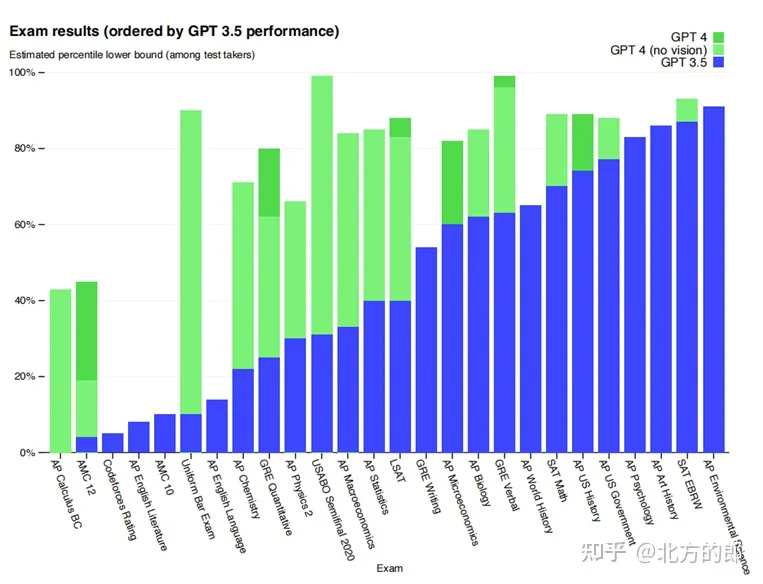

GPT-4:GPT- 4 是 OpenAI 在 2023 年发布的最新一代模型。在随意谈话中 ,ChatGPT 和 GPT- 4 之间的区别是很微妙的。只有当任务的复杂性达到足够的阈值时 , 差异就出现了 ,GPT- 4 比 ChatGPT 更可靠、更有创意 , 并且能够处理更细微的指令。为了了解这两种模型之间的差异 ,OpenAI 在各种基准测试和一些为人类设计的模拟考试上进行了测试 , 并且取得了非常好的结果。同时 GPT- 4 有很强的多模态能力 , 可以理解图片。

技术发展特点

模型规模的不断增大 : 从 GPT-1 的 117M 到 GPT-3 的 175B, 模型规模不断增大 , 使得模型可以处理更复杂的自然语言任务。

技术创新的不断引入 :GPT 系列模型在每一代升级中都引入了新的技术创新 , 如多头注意力机制、动态掩码、递归神经网络和生成器 - 判别器结构等 , 使得模型性能不断提升。

应用场景的不断扩展 : 从 GPT-1 的文本生成到 ChatGPT 的对话任务 ,GPT 系列模型在应用场景的不断扩展中 , 不断拓展了模型的应用范围。

部分关键论文及技术文档 :

1.Attention Is All You Need (Transformer)

2.BERT Pre-training of Deep Bidirectional Transformers for Language Understanding(BERT)

3.Improving Language Understanding by Generative Pre-Training(gpt)

4.Language Models are Unsupervised Multitask Learners (gpt2)

5.Language Models are Few-Shot Learners (gpt3)

6.Training language models to follow instructions (Instruct gpt)

7.GPT-4 Technical Report (gpt4)

原文链接:https://blog.csdn.net/hawkman/article/details/130100177