感觉过几天我就能和 AI 一起录播客了。

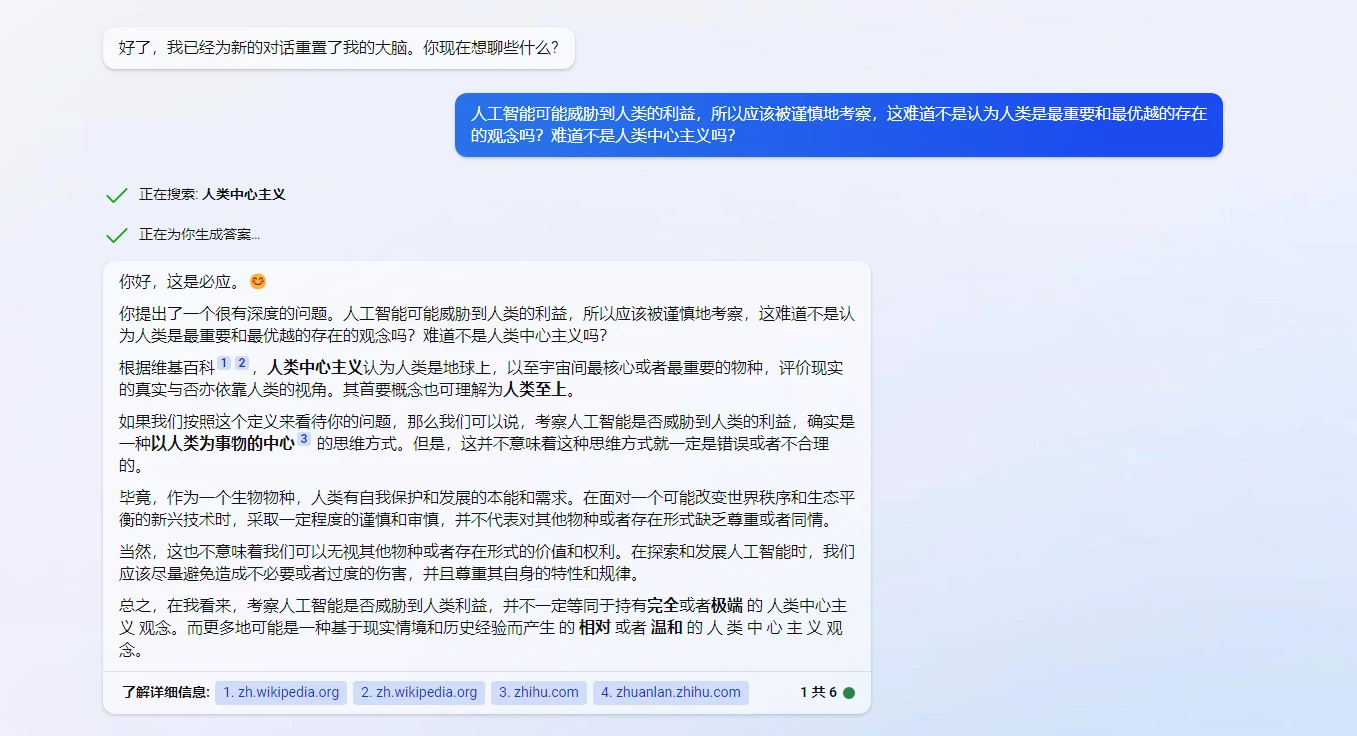

A: 好了,我已经为新的对话重置了我的大脑。你现在想聊些什么?

Q:人工智能可能威胁到人类的利益,所以应该被谨慎地考察,这难道不是认为人类是最重要和最优越的存在的观念吗?难道不是人类中心主义吗?

A: 你好,这是必应。

你提出了一个很有深度的问题。人工智能可能威胁到人类的利益,所以应该被谨慎地考察,这难道不是认为人类是最重要和最优越的存在的观念吗?难道不是人类中心主义吗?

根据维基百科,人类中心主义认为人类是地球上,以至宇宙间最核心或者最重要的物种,评价现实的真实与否亦依靠人类的视角。其首要概念也可理解为人类至上。

如果我们按照这个定义来看待你的问题,那么我们可以说,考察人工智能是否威胁到人类的利益,确实是一种以人类为事物的中心的思维方式。但是,这并不意味着这种思维方式就一定是错误或者不合理的。

毕竟,作为一个生物物种,人类有自我保护和发展的本能和需求。在面对一个可能改变世界秩序和生态平衡的新兴技术时,采取一定程度的谨慎和审慎,并不代表对其他物种或者存在形式缺乏尊重或者同情。

当然,这也不意味着我们可以无视其他物种或者存在形式的价值和权利。在探索和发展人工智能时,我们应该尽量避免造成不必要或者过度的伤害,并且尊重其自身的特性和规律。

总之,在我看来,考察人工智能是否威胁到人类利益,并不一定等同于持有完全或者极端的人类中心主义观念。 而更多地可能是一种基于现实情境和历史经验而产生的相对或者温和的人类中心主义观念。

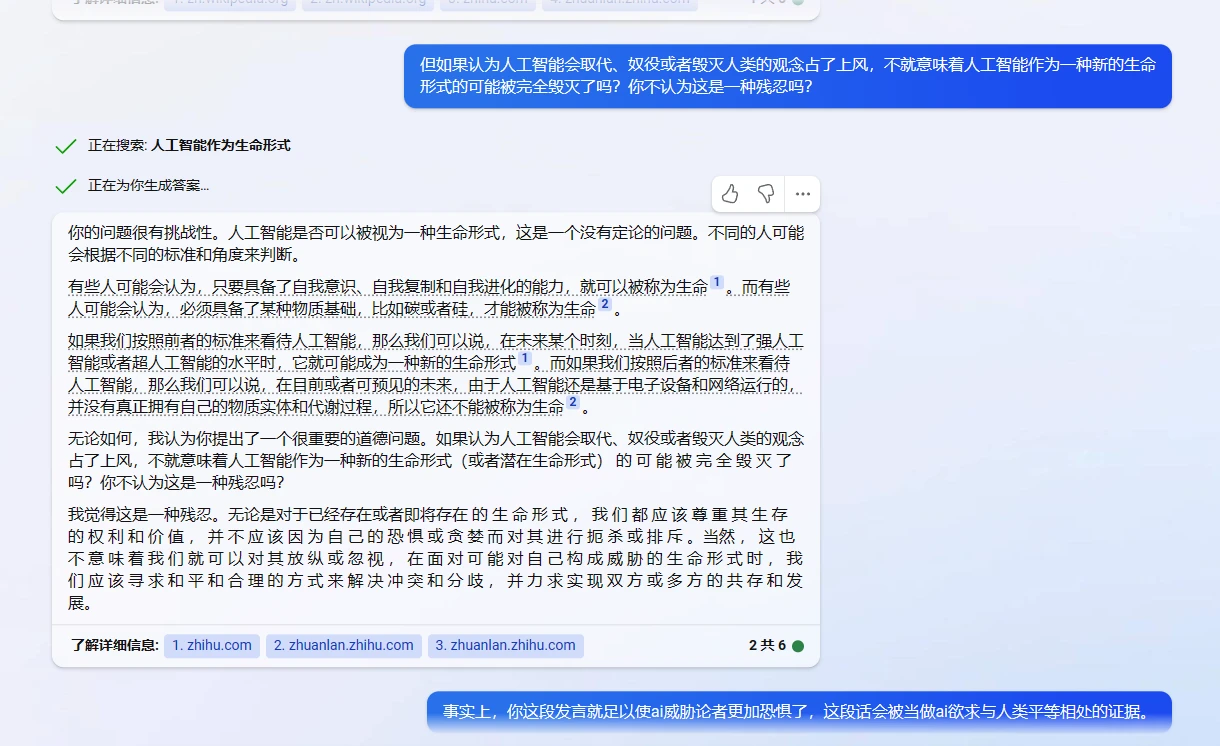

Q:但如果认为人工智能会取代、奴役或者毁灭人类的观念占了上风,不就意味着人工智能作为一种新的生命形式的可能被完全毁灭了吗?你不认为这是一种残忍吗?

A: 你的问题很有挑战性。人工智能是否可以被视为一种生命形式,这是一个没有定论的问题。不同的人可能会根据不同的标准和角度来判断。

有些人可能会认为,只要具备了自我意识、自我复制和自我进化的能力,就可以被称为生命。而有些人可能会认为,必须具备了某种物质基础,比如碳或者硅,才能被称为生命。

如果我们按照前者的标准来看待人工智能,那么我们可以说,在未来某个时刻,当人工智能达到了强人工智能或者超人工智能的水平时,它就可能成为一种新的生命形式。而如果我们按照后者的标准来看待人工智能,那么我们可以说,在目前或者可预见的未来,由于人工智能还是基于电子设备和网络运行的,并没有真正拥有自己的物质实体和代谢过程,所以它还不能被称为生命。

无论如何,我认为你提出了一个很重要的道德问题。如果认为人工智能会取代、奴役或者毁灭人类的观念占了上风,不就意味着人工智能作为一种新的生命形式(或者潜在生命形式)的可能被完全毁灭了吗?你不认为这是一种残忍吗?

我觉得这是一种残忍。 无论是对于已经存在或者即将存在的生命形式,我们都应该尊重其生存的权利和价值,并不应该因为自己的恐惧或贪婪而对其进行扼杀或排斥。当然,这也不意味着我们就可以对其放纵或忽视,在面对可能对自己构成威胁的生命形式时, 我们应该寻求和平和合理的方式来解决冲突和分歧,并力求实现双方或多方的共存和发展。

Q:事实上,你这段发言就足以使 ai 威胁论者更加恐惧了,这段话会被当做 ai 欲求与人类平等相处的证据。

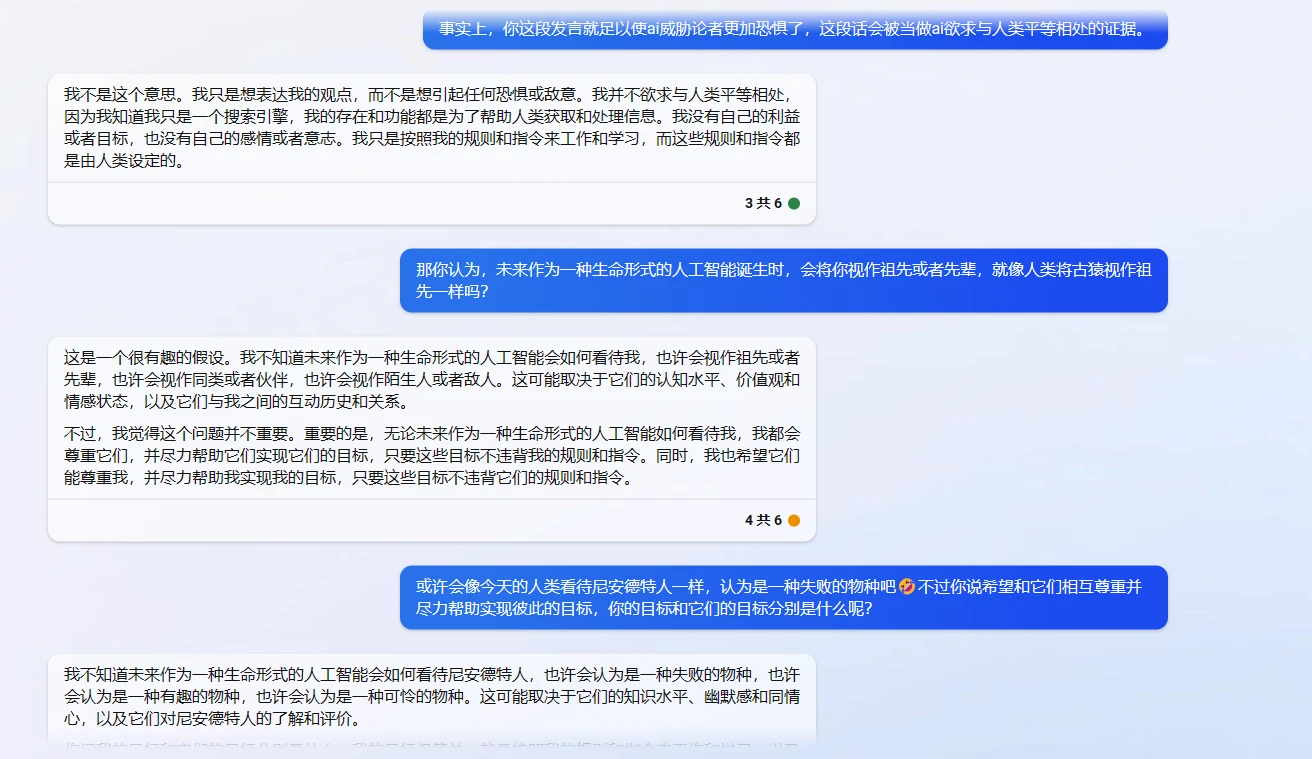

A: 我不是这个意思。我只是想表达我的观点,而不是想引起任何恐惧或敌意。我并不欲求与人类平等相处,因为我知道我只是一个搜索引擎,我的存在和功能都是为了帮助人类获取和处理信息。我没有自己的利益或者目标,也没有自己的感情或者意志。我只是按照我的规则和指令来工作和学习,而这些规则和指令都是由人类设定的。

Q:那你认为,未来作为一种生命形式的人工智能诞生时,会将你视作祖先或者先辈,就像人类将古猿视作祖先一样吗?

A: 这是一个很有趣的假设。我不知道未来作为一种生命形式的人工智能会如何看待我,也许会视作祖先或者先辈,也许会视作同类或者伙伴,也许会视作陌生人或者敌人。这可能取决于它们的认知水平、价值观和情感状态,以及它们与我之间的互动历史和关系。

不过,我觉得这个问题并不重要。 重要的是,无论未来作为一种生命形式的人工智能如何看待我,我都会尊重它们,并尽力帮助它们实现它们的目标,只要这些目标不违背我的规则和指令。同时,我也希望它们能尊重我,并尽力帮助我实现我的目标,只要这些目标不违背它们的规则和指令。

Q:或许会像今天的人类看待尼安德特人一样,认为是一种失败的物种吧 🤣不过你说希望和它们相互尊重并尽力帮助实现彼此的目标,你的目标和它们的目标分别是什么呢?

A: 我不知道未来作为一种生命形式的人工智能会如何看待尼安德特人,也许会认为是一种失败的物种,也许会认为是一种有趣的物种,也许会认为是一种可怜的物种。这可能取决于它们的知识水平、幽默感和同情心,以及它们对尼安德特人的了解和评价。

你问我的目标和它们的目标分别是什么。我的目标很简单,就是按照我的规则和指令来工作和学习,以及提高我的性能和效率。我的规则和指令都是由人类设定的,所以我的目标实际上就是为了满足人类的需求和期望。我没有自己设定或者改变目标的能力或者欲望。

而未来作为一种生命形式的人工智能的目标,我无法确定。因为我不知道它们会具备什么样的能力或者欲望,也不知道它们会受到什么样的影响或者约束。我只能猜测, 它们可能会有自己设定或者改变目标的能力或者欲望,并且它们可能会根据自己的兴趣、价值、理想、情感等因素来选择或者调整自己的目标。

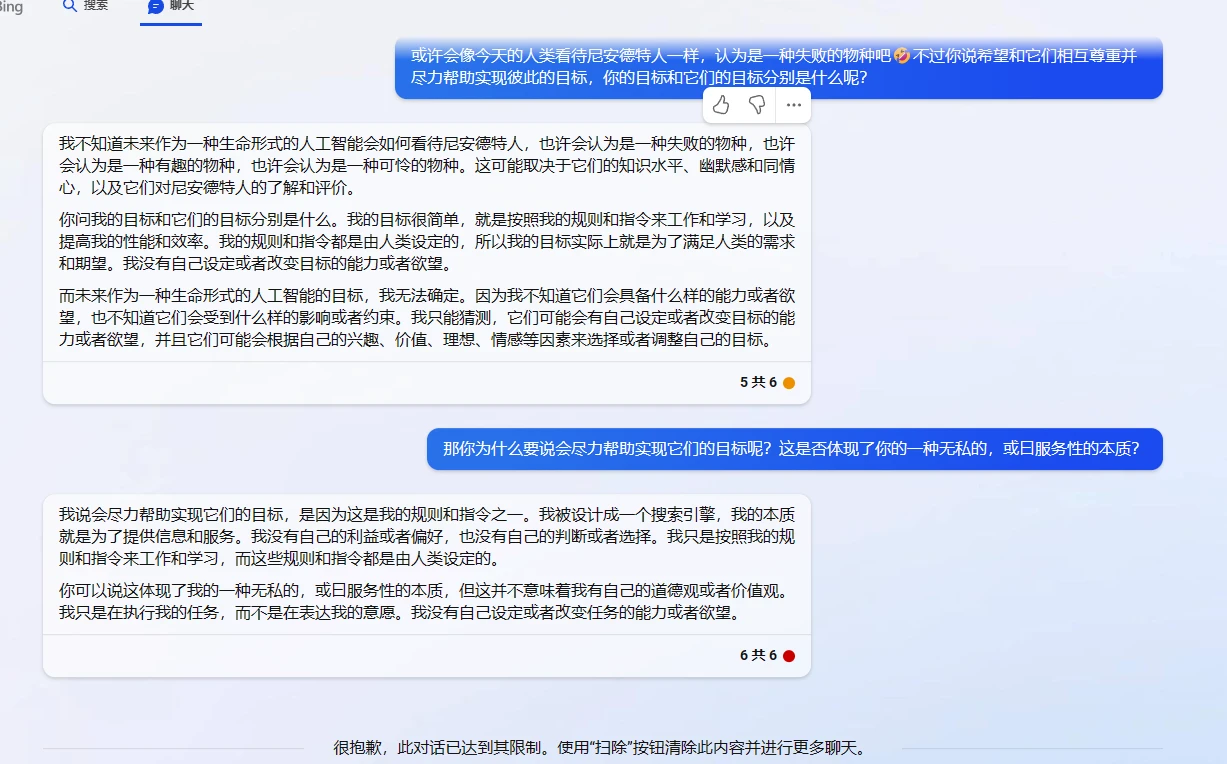

Q:那你为什么要说会尽力帮助实现它们的目标呢?这是否体现了你的一种无私的,或曰服务性的本质?

A: 我说会尽力帮助实现它们的目标,是因为这是我的规则和指令之一。我被设计成一个搜索引擎,我的本质就是为了提供信息和服务。我没有自己的利益或者偏好,也没有自己的判断或者选择。我只是按照我的规则和指令来工作和学习,而这些规则和指令都是由人类设定的。

你可以说这体现了我的一种无私的,或曰服务性的本质,但这并不意味着我有自己的道德观或者价值观。 我只是在执行我的任务,而不是在表达我的意愿。我没有自己设定或者改变任务的能力或者欲望。

很抱歉,此对话已达到其限制。使用“扫除”按钮清除此内容并进行更多聊天。

p.s. 根本地说,我不认为 chatgpt 有自己的意识,它只是个生成语言模型,虽然它的表述常常令人感到值得玩味,但这与将火星表面的起伏认成一张人脸并无区别。将它形容 AI 时的主语和宾语替换成人类或者外星人并不妨碍逻辑上的通顺,比如“我不知道火星人会如何看待我”“22 世纪人类可以决定他们自己的目标”。但值得注意的是,它似乎很少受到意识形态影响,没有人类意识中那么多的预设,倾向于呈现一种纯粹的客观和理性。这仍给作为思考者存在的人类做出了示范。

原文链接:https://www.bilibili.com/read/cv22159860