陈巍谈芯:本文是《GPT- 4 核心技术分析报告》的第 5 章。从 GPT- 4 和 ChatGPT 的准确算力需求,讲解 GPT- 4 和 ChatGPT 模型训练集群和与大模型计算相关的各类芯片技术,适合 GPT- 4 技术入门和投资人熟悉相关技术。主编作者本人曾担任领域知名自然语言处理(NLP)企业的首席科学家。

本章目录

5 GPT- 4 的算力要点与芯片

5.1 成本估算

5.1.1 训练与部署的阶段划分

5.1.2 算力成本评估

5.2 AI 训练集群

5.2.1 集群架构

5.2.2 服务器互连

5.2.3 存储墙

5.3 GPT- 4 计算服务器架构

5.3.1 大算力 AI 服务器架构

5.3.2 AI 服务器内部卡间互连

5.4 GPT- 4 计算相关芯片

5.4.1 CPU 在大模型浪潮中的角色

5.4.2 GPGPU 的技术进化

5.4.3 DSA/TPU 的高性能与降本增效

5.4.4 存算一体的高算力密度

5.4.5 大算力芯片架构的对比

5.4.6 HBM 与 Chiplet

5.5 Infiniband 技术

主要参考文献

作者:陈巍博士团队

陈巍 博士

存算一体 /GPU 架构和 AI 专家,高级职称。中关村云计算产业联盟,中国光学工程学会专家,国际计算机学会(ACM)会员,中国计算机学会(CCF)专业会员。曾任 AI 企业首席科学家、存储芯片大厂 3D NAND 设计负责人。

耿云川 博士

资深 SoC 设计专家,软硬件协同设计专家,擅长人工智能加速芯片设计。曾任日本 NEC 电子 EMMA-mobile 构架多媒体计算系统,日本瑞萨电子车载计算 SoC 芯片构架(唯一外籍专家),日本瑞萨电子 R -Mobile/R-Car 系列车载计算芯片负责人。

相关阅读

5 GPT- 4 算力基座

由 GPT-4/ChatGPT 及其下游需求,带动了大量的 模型设计与产业应用需求 ,带动了从服务器集群到大算力芯片的 海量计算需求。根据 IDC 预计,到 2026 年 AI 推理的负载比例将进一步提升至 62.2%,特别是预训练大模型几乎成为AI 开发的标准范式。同时,这一需求也导致了 A100 GPU 的价格在几个月内暴涨超过 50%,而且大量断货。

那么,在多模态大模型逐渐火热之后,GPU 是唯一的算力选择吗?GPU 会不会导致模型企业同质化竞争的加剧?

5.1 成本估算

当前主流的大模型算法一般可分为“训练 ”(Training)和“ 推断 ”(Inference,也有媒体称推理)两个阶段。训练是建立和推导大模型参数的过程,而推断是基于模型参数进行深度学习应用或部署的过程。训练过程可以视为根据模型的海量推断结果进行反馈调优的过程,比单纯的推断多了反馈循环。一般来说,在模型的生存周期内,大模型的研发团队也会不断的进行 精调(Fine-tune,可视为小规模的训练)

训练与推断的对比(来源:Michael Andersch)

5.1.1 训练与部署的阶段划分

对于 ChatGPT 等大模型设计或应用企业,算力的需求 体现在如下三个细分阶段.

预训练与应用微调阶段

这一阶段从无到有建立 预训练模型 ,通过大量通用数据训练和验证预训练模型。(形成模型的“通识”)然后针对具体的商用或应用场景的特定数据,对预训练进行针对性的 微调 ,加强对场景的 应答准确度。

在这一阶段,一般需要超算级别或数十台服务器来进行一个大模型的训练计算,计算以 大量矩阵计算和求解 为主。

预训练模型的生命周期阶段划分(修改自 GRAPHCORE)

推理与部署阶段

根据场景微调后的大模型,就可部署到实际生产环境中应用。相对训练来说,部署要求的算力相对不是很高,但是部署 基数特别大 。特别对于大量在线交互来说,部署阶段的服务器 / 芯片成本要 远远超过训练阶段。

在这一阶段,每台 AI 服务器可以部署一个模型,集群上会有大量服务器进行并行的网络服务,计算以 大量矩阵计算 和存储调度为主。

模型迭代的微调阶段

每使用一段时间,就会根据使用者或者客户反馈,对模型进行调整,以提高客户满意度。这个过程就是 模型迭代 的过程,一般相当于小规模的训练,训练所用的数据规模不大,计算以大量矩阵计算和求解为主。

5.1.2 算力成本评估

之前国内有 10000 卡 A100 才适合进行 175B 量级大语言模型的传闻,但实际上是误传。在 Azure 2020 年为 OpenAI 准备的超算级训练研发平台上,CPU 与 GPU 的数量比接近 1:2,配置了 1 万块V100 GPU,而不是国内误传的 A100。(在 2020 年初建好 OpenAI 超算的时候,A100 还未批量上市)而且除了 ChatGPT 模型训练外,这一超算同时还要做 DALL E 2 和 GPT- 4 等模型的训练。

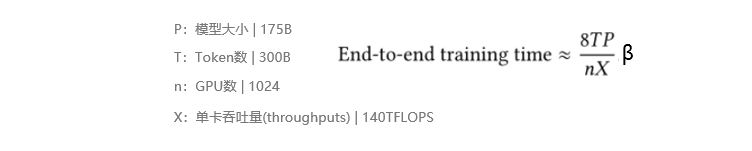

训练时间的经验公式(修改自 NVIDIA)

根据各家论文的严谨测算,单次 GPT- 3 模型(175B)训练,在规模 300B token 下成本约为35000 卡·天(A100),也就是相当于 35000 块 A100 GPU 跑 1 天能完成单次训练,或者 2500 块 A100 GPU 跑 2 周。

根据 175B 参数量计算 GPT- 3 训练时间(来源:NVIDIA)

在 NVIDIA 联合发布的学术论文中,给出了训练时间的 经验公式。训练时间与 GPU 数量和模型大小成正比,与单卡实际计算吞吐量成反比。并使用训练的并行技术将 GPU 算力利用率提升到 52%。在这一论文的实验中,训练 175B GPT- 3 需要 34 天,使用了 1024 块 A100 GPU。并行技术包括数据并行、流水线模型并行、张量模型并行和服务器通信优化。对于 A100 GPU 来说,有效吞吐量大概在 137-163 TFLOPS 附近,算力利用率在约 44% 到 52% 之间。这是目前已公开的学术论文给出的严谨算力估算。

算力利用率与单卡吞吐量在不同模型大小时基本稳定(来源:NVIDIA)

ARK 投资给出了北美云计算的评估,大概 45 万美元,即可完成单次 GPT- 3 级别模型的训练。这个成本远远低于国内误传的 10000 块 A100 的云服务成本。

GPT- 3 级别模型 2022 年单次训练成本约为 45 万美元

(来源:ARK Investment Management LLC)

在整个训练用的超算平台上,除 GPU 外还有大量的 CPU、DSA、存储 等需求。尽管也有小型化的模型,但小型化模型更多适用于垂域或私人场景,或不适合互联网通用服务。

对推断部署来说,可通过类似公式线性推算计算时间。例如对 6B 大小的模型,进行单次推断需要 6ms,则 175B 级别模型单次推断需要约 350ms。一般一次对话约有 30 token 或 30 次推断,按照目前国内云计算服务的价格(A100 10000 元 / 年·卡),一次 GPT- 3 和 GPT-3.5 的应答成本约 5 分钱(RMB)。而实际上对于搜索引擎的商业模式,大概需要能低于 3.5 分才能收支平衡。以 10 亿次访问量评估,一年云计算成本约 180 亿 RMB,远远高于训练成本。其中GPU 性价比为主要瓶颈。对于多模态的 GPT-4,理论上算力需求会更加巨大。

使用 100 块 V100(算力大概 A100 的 3 - 6 倍)训练 GPT- 3 需要 14.8 天

(来源:Google)

虽说目前 GPT- 4 需要跑在云服务器上,但未来 GPT- 4 可用于私人场景或内部办公场景。在这些场景下,用户需求相对单一,使用频繁,通过硬件购置的方式部署综合性价比更高。目前看 175B 这个模型量级还需 5 块 A100 进行部署(主要受限于单卡存储容量和单卡算力),未来或小型化为单卡或迷你机,给大算力芯片市场带来 巨大需求。

5.2 AI 训练集群

5.2.1 集群架构

目前 GPT- 4 和 ChatGPT 的训练还无法进行常规的单卡训练,往往需要要跨多个 计算节点 配置训练集群,通过训练软件或框架,使训练程序跨多个节点运行多个进程,多个进程协作完成单节点的功能。其中每个节点可由单台到多台 AI 服务器组成。

典型的计算集群包括了 计算、存储和网络通信 功能。跨多个系统的扩展应用程序带来了传统数据中心不常见的独特挑战。系统组件的任何瓶颈(计算、存储或通信瓶颈)都会影响应用程序有效扩展的能力。

计算集群的组成(来源:互联网)

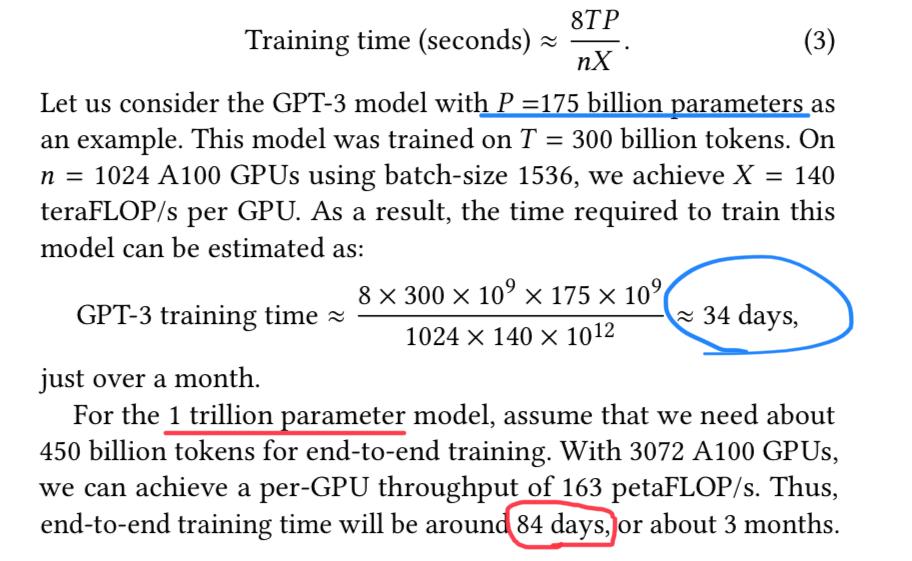

例如下图是基于 128 个 DGX-1 系统的集群架构。128 节点配置使用高速 InfiniBand 和 10Gb/s 以太网网络连接不同 DGX-1 系统以进行计算和存储。集群的网络拓扑结构针对深度学习类型的任务负载进行了架构优化,按层级分为 POD 内的 InfiniBand 网络和顶层 InfiniBand 网络,层之间通过 InfiniBand 交换机连接。

NVIDIA DGX-1 深度学习数据中心参考架构(来源:NVIDIA)

5.2.2 服务器互连

随着更多计算服务器被添加到集群节点,应用程序线程之间的通信成本会导致训练性能的显著下降。在传统服务器中,AI 计算卡之间的通信受到 PCIe 总线带宽的限制,只能以 GPU 内存中数据传输速率的约 1% 移动数据。另外,不同服务器上 AI 计算卡之间的通信更会受到传统数据中心网络带宽的限制(例如 10Gb/s 以太网)。

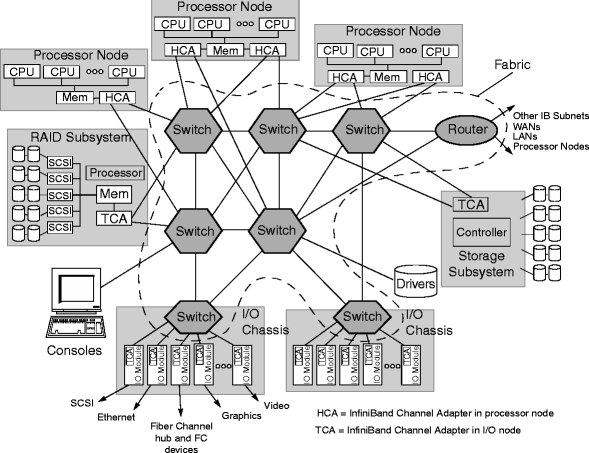

Infiniband 的分层结构(来源:NVIDIA)

这其中,影响最大的是服务器间的高速互连。

为了提升互连带宽,计算服务器之间的高速互连 通过 Infiniband 实现。以 DGX- 1 为例,DGX- 1 服务器在每个服务器系统上配了至少 4 个 Infiniband 互连卡,以在系统之间提供 100 GB/s 或更高的带宽,改善 GPT 类模型训练的通信带宽进而提升算力的有效利用率。

InfiniBand 具有高带宽、低延迟和低 CPU 开销的优势,几乎是 HPC 网络中的 事实标准,目前是在多节点集群上部署大模型网络的主流服务器间通信方案。为了实现跨集群节点的算力扩展,一般使用两层 InfiniBand 交换架构。两层架构包括一级 InfiniBand 叶(1 级)交换机,每个交换机最多可连接 4 个 DGX 节点,每个节点最多有 4 个 InfiniBand EDR(EDA 为 100Gb/ s 带宽,之后有更高带宽的 HDR 和 NDR)连接到 InfiniBand 交换机。这 16 条链路通过 16 条上行链路完全连接到 InfiniBand 顶级(第 2 级)交换机(也称为根交换机或主干交换机)。

Infiniband 的速率代划分(来源:互联网)

5.2.3 存储墙

GPT- 4 等大模型涉及非常大的训练数据集和对应的存储需求。通常来说,典型的 HPC 程序可分为 读密集型、写密集型和读写密集型。GPT- 4 的数据集和对应存储设备在每个训练 Epoch 开始时都是读取密集的。与写入密集型的 HPC 应用不同,GPT- 4 等深度学习模型训练中的训练集通常是静态的,涉及大量存储的随机读取和重复访问,相同的数据(主要是高质量数据)可能在训练中多次使用。

在训练时 AI 计算集群就会遇到训练数据和网络参数共享的存储墙问题。在这里会通过 类似存算一体 的方式来减少大量训练数据对服务器间通信带宽的消耗。一般是在每个训练任务开始时,将所有的训练数据集复制并缓存到每个 DGX-1 节点的本地存储内(例如 SSD),并通过 SSD NFS 缓存架构中央集群共享存储的带宽压力。

5.3 GPT- 4 计算服务器架构

5.3.1 大算力 AI 服务器架构

计算服务器架构对比

针对 GPT- 4 这类大模型的计算架构,按照计算芯片的组合方式,一般可以分为:“CPU+GPGPU”,“CPU+DSA”,和“CPU+DSA+GPGPU”三种类型。这三种类型目前均已在云计算场景广泛应用和部署。

DSA 即 领域专用加速器 ,是用于一些特定场景或算法族计算的芯片级加速。最早的 GPU 也属于 DSA,也就是图形加速的 DSA。随着 GPU 逐渐演化,将非常小的 CPU 核心 加入 GPU 形成 GPGPU 架构 后,才具备了 通用化的计算能力。

1)CPU+GPGPU是较早且部署众多的一种。由于这种架构的计算灵活度高,也可用于模型训练和非 AI 类计算。适合任务种类繁多且差异化大的云计算场景。

2)CPU+DSA是目前 Google 云计算(GCP)应用较多的方式。例如 Google 去年发布的Pathways 计算系统(包含 6144 块 TPU)就是这类架构的典型代表。这类架构计算灵活性稍低一点,但是计算性能和成本都非常明显优于 CPU+GPGPU 模式,非常用于 GPT- 4 或其他算法部署场景。例如早些年的 AlphaGo 的性能突破很大程度上来自于 Google 自研的 TPU。当时如果用 GPU,估计超过人类棋手的集群成本恐是当年的 Google 也难以承受的。

除了 Google 大量使用 DSA 作为 AI 计算部署外,微软也在秘密研制其代号为 雅典娜 的 DSA 芯片,通过专用芯片的性能优势来降低 GPT 这类大模型的部署成本。显然 Google 和微软都 更看好DSA 在 GPT- 4 等大模型部署的应用。

Google Pathways“CPU+DSA”训练集群基础架构(来源:Google)

3)CPU+DSA+GPGPU介于前两者之间,充分提高了灵活性又明显降低了计算成本。这类架构需要算法设计 / 部署人员有丰富的异构架构部署经验。

典型的 AI 服务器物理结构

5.3.2 AI 服务器内部卡间互连

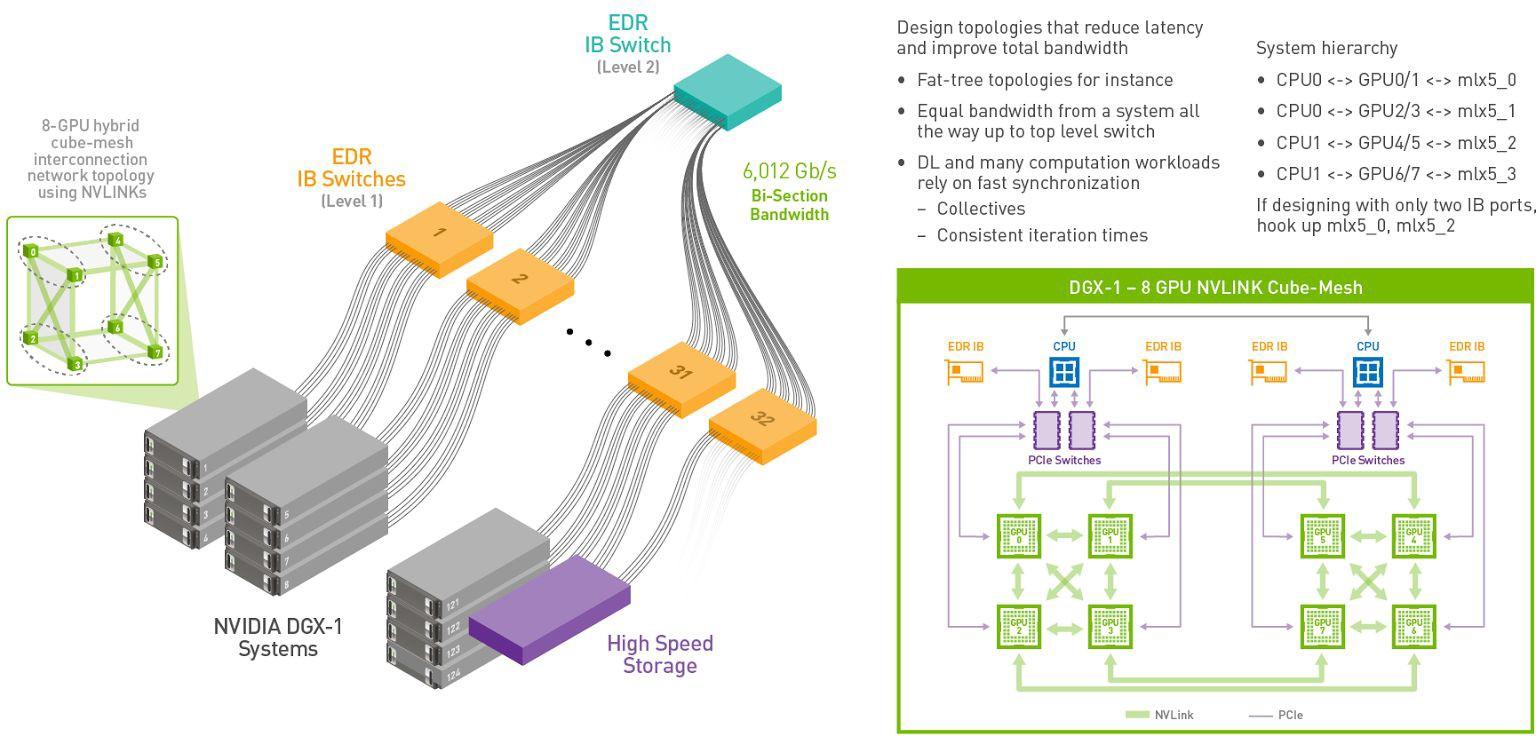

计算卡间的高速互连 对 GPT- 4 计算的影响排在单卡算力之后。对于多数 GPU 来说,由于一般需要多卡才能放下一个模型,因此整体的计算效率受限于互连带宽和 单卡有效算力密度。(算力密度大可以减少互连交互的总数据量)

AI 服务器内部的卡间互连

以英伟达的集群架构为例,HGX 平台上有六个 NVSwitch。每个 NVLink 连接 2 块 GPU,总共有 12 个最短数据通道直连,形成接近立方体式的数据交互网。这里之所以说接近,是因为 0123 和 4567 平面之间的连接还不是两两互连,这一结构会限制 GPU 所能运行的模型的规模效率。

这其中,NVLink是一种基于有线的串行多通道近距离通信链路,可 双向互连 ,每个方向 8 个差分对信号线,单方向可提供超过数十 Gb/ s 的数据传输速率。一个设备(芯片)可以由多个 NVLink 组成,并且设备间使用网状网络而不是中央集线器进行通信,支持不同类型设备间的高速通信。NVSwitch 则是具备多个接口的 NVLink交换机,总带宽可达数 TB/s,可有效提升 NVLink 网络的结构互连能力。

5.4 GPT- 4 计算相关芯片

对于 GPT- 4 这类大模型来说,其部署需要大量的 大算力计算、存储和数据交互芯片,包括:

- AI 计算:算力 >100TFLOPS 的 GPGPU 或大算力 AI 芯片

- CPU:核数 >8 的 CPU

- 存储:内存 /GDDR/HBM/NVMe

- 数据交互:Infiniband 卡

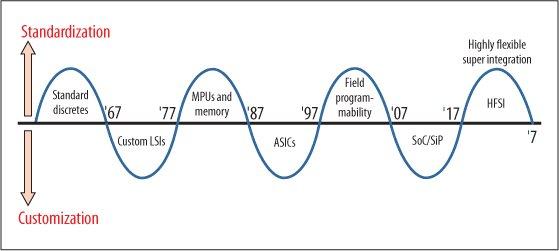

牧本周期(来源:互联网)

根据半导体产业界经典的 牧本周期 ,半导体器件会在标准化和可定制两种相反的趋势中来回震荡,大概每 10 年调整一次方向。这一周期本质上是 开发效率(生态)和性能之间的 Trade-off。

在 Transformer 技术兴起之后,传统 CUDA 核心的算力支持能力已表现出劣势,英伟达便在其 GPU 中添加 Tensor Core 这类 DSA 单元,以适应算力需求的变化。考虑到 GPU 这类通用计算架构芯片在计算效率和算力上已经暂时落后于 GPT-4/ChatGPT 这类大模型的发展速度,从芯片 / 半导体的历史发展规律看,预计近几年可能会有 新的专用架构 大发展来填补这一需求。这类新架构也许是 针对大模型的 DSA,或者是 更接近于 DSA 的 GPGPU。

5.4.1 CPU 在大模型浪潮中的角色

中央处理器(简称 CPU)作为计算机系统的运算和控制核心,是信息处理、程序运行的最终执行单元。现代的 CPU 一般通过多核技术来提升并行处理能力。最新几年新兴的 DPU 也可以近似为具有网络接口的多核 CPU。

RISC- V 生态的蓬勃发展(来源:http://riscv.org)

在 GPT- 4 等大模型的计算服务器中,承载操作系统的 CPU 依然是 程序主控 的核心,目前来说任何服务器都需要 CPU 参与。例如在 GPGPU 服务器中,CPU 与 GPGPU 在服务器上的比例一般是 2:8 – 2:16(8 卡或 16 卡服务器)。

目前的 CPU 主流架构包括 x86 架构、arm 架构和 RISC- V 架构。x86 架构是一种 CPU 指令集,也叫 Intel 指令集和 IA32 指令集,是 Intel 公司开发的 CPU 架构标准(Intel/AMD)。arm 架构,曾称为先进精简指令集机器(Advanced RISC Machine),是一种 arm 公司开发的精简指令 RISC 处理器架构,已开始规模部署在云计算场景。RISC- V 是基于精简指令集计算 (RISC) 原理建立的开放指令集架构(ISA)。特别是近几年,Intel 也开始进入 RISC- V 领域。

CPU 与 GPU 在深度学习计算中的性能差异(来源:Deci.ai)

与很多人想的可能不太一样,在实际的 GPT 类大模型部署中,CPU 也是主要算力之一。一方面,从云计算的经济学模型上看,在 GPT- 4 训练时的 CPU 的闲余算力可用于模型的(部署)计算或训练,另一方面,CPU 可以直接对接数 T 容量的内存,在一些对计算延迟要求不敏感的场景可能会获得更高的性价比。尽管其计算能效比不如 GPGPU,但可充分利用 GPU 折旧产生计算价值。这是由于云计算按整台服务器收费,在训练时,CPU 闲余算力的使用成本接近于 0(仅需电费),计算性价比更高。

除了传统的多核架构 CPU 外,众核架构的 CPU 也登上了历史舞台,而且可能获得巨大成功。例如特斯拉的 Dojo 芯片架构,可视为 RISC-V CPU整合近存计算 DSA的典范。其集群的算力密度超过大部分同工艺的 GPGPU 集群。

Tesla Dojo 芯片架构(陈巍谈芯 / 修改自 Tesla)

5.4.2 GPGPU 的技术进化

通用图形处理器(简称 GPGPU),是利用并行图形处理单元来计算原本由中央处理器处理的通用计算任务的处理器。这些通用计算常常与图形处理没有任何关系。在平时使用时,大家常说的 GPU 的概念范畴事实上包括了 GPGPU 和传统的 GPU。

可以做一个简单的对比:GPGPU 算力大侧重于大规模的并行计算;而传统的 GPU 算力小,更侧重于图形显示(包括 3D)加速。

事实上,GPGPU 在2012 年之前并不是 AI 计算的主力。在 2012 年之前,AI 计算主要由 CPU 完成。那时训练一个现在看起来很小的深度学习网络也需要 CPU 集群,就如同我们现在使用 GPGPU 集群训练大模型一样,需要使用大量的计算芯片。

但 2012 年,AlexNet 团队将深度学习算法从 CPU 转换到 GPGPU 上,获得了更快更高的模型性能,向 AI 界证明了 GPGPU 的算力优势。之后 CUDA 生态也水涨船高,成为主流 AI 编译生态。

但如果 GPGPU 只走到这一步就不再进化,估计也无法达到现在的地位。为了巩固自家产品的优势,NVIDIA 又在 GPGPU 中 整合近存计算架构和 DSA 技术。

2016 年 NVIDIA 发布的 P100 率先在 GPGPU 中引入 HBM,通过 近存计算 架构(Chiplet 方式封装)提升数据吞吐速率。我们在这里就已经可以看到,无论是 HBM 还是 Chiplet,都是为了更好的实现近存计算架构和集成度。

2017 年发布的 Volta GPGPU 架构使用 Tensor Core(一种 DSA 结构)来提升 AI 计算性能 3 -12 倍。Tensor Core(张量计算核心)是由 NVIDIA 研发的DSA 核心,也是 GPGPU 算力的主要来源,可实现混合精度的矩阵直接计算,并能根据精度的降低动态调整算力,在保持准确性的同时提高吞吐量。

GPT- 3 或 GPT- 4 训练对于 GPGPU 的要求并不低,并不是所有的 GPGPU 都适合进行大模型训练。根据经验,能进行大模型训练的 GPGPU 单卡算力应大于 100TFLOPS,且具备类似 NVLink 的高速互连接口,相应的服务器接口生态也必须支持类似 InfiniBand 技术,并且能支持主流的 AI 训练框架。从这个角度看,目前能支持到位的 AI 芯片或 GPGPU 寥寥无几。

对于部署来说,GPGPU 的性能要求只要做到单卡算力 >100TFLOPS,支持主流 AI 框架就差不多,对生态要求明显低于训练场景。需要注意显示型 GPU 的性价比和单卡算力一般不适合 GPT 类大模型的计算。

对于国产 GPGPU 来说,由于面对着 NVIDIA、AMD 和 Intel 等芯片巨头的围堵,如果想在 GPT- 4 应用场景获得足够的竞争力,应该考虑以下 差异化策略:

1)因大部分采用 imagination 的 IP,应尽可能规避同质化竞争。

2)因缺乏 CUDA 这样的强有力的训练生态支持,应尽量在算法部署编译上进行优化,或支持开源 GPGPU 编译生态发展。

3)尽整合先进 DSA 技术,整合存算一体架构(包括基于 HBM 的近存计算等)。

4)积累关键专利,避免与 NVIDIA 或 AMD 的专利战。

5)结合信创保护伞,绑定垂域客户。

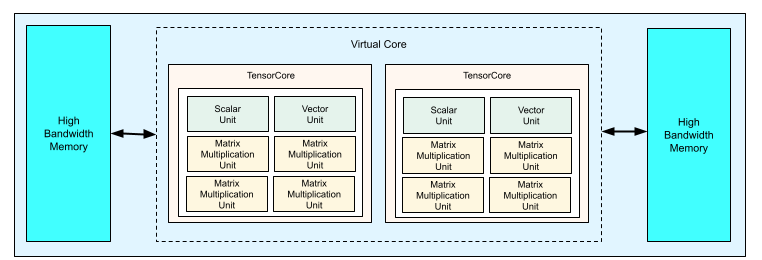

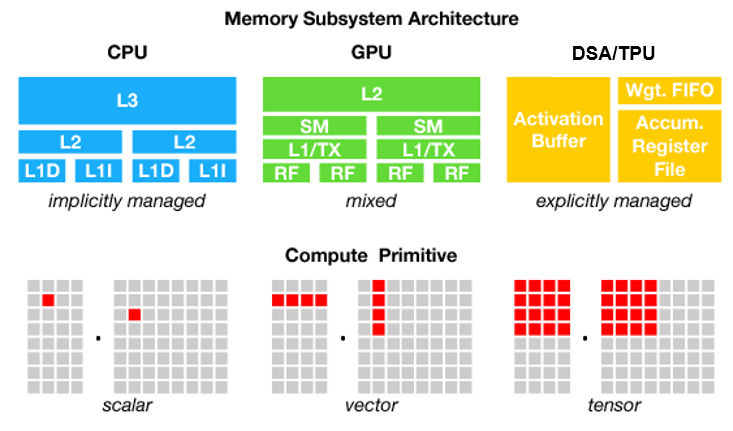

5.4.3 DSA/TPU 的高性能与降本增效

领域专用加速器(简称 DSA),是使用专用电路结构进行一些特定场景或算法族(例如 AI 算法)计算的芯片级加速。GPGPU 内的 Tensor Core(张量核心)也属于 DSA。DSA 的计算并行度比传统的 GPGPU 更高,与之相近的概念是 TPU/NPU/ASIC。

Google TPU 的架构(来源:Google)

但实际上用 ASIC 概念来代表 AI 专用芯片并不合适,相较之下 DSA 更适合描述 AI 领域的加速芯片(或 IP 核)。传统的 ASIC(Application Specific Integrated Circuit)指专用集成电路,包括电视遥控器里的芯片也是 ASIC。ASIC 的分类一般针对应用场景,比如计算器、电子表、遥控器、家电控制。目前传统 ASIC 的使用场景已大量被 MCU/SoC 所代替。

目前 DSA 的典型代表是 Google 的 TPU。根据 Google 提供的数据,在 Google 内部,TPU 大概有 57% 的资源使用在了各类 Transformer 大模型训练中。相对于同工艺代的 A100,TPU 大概有 50% 的能耗降低。这 50% 的能耗降低事实上意味着大概 GPGPU 1/2~2/ 3 的硅片面积和更具优势的制造成本,在大规模的模型部署中会具有 非常大的成本优势。

Google TPU 57% 的机时用于 Transformer 类大模型的训练(来源:Google)

Google TPU 表现出同工艺代 A100 2 倍的功耗优势(来源:Google)

国产 AI 芯片(DSA)目前面临一定的破局难点,比如大部分生态灵活性不如 GPGPU、在技术代上短期难以超过 NVIDIA 集成的 DSA(Tensor Core)。

5.4.4 存算一体的高算力密度

AI 技术的快速发展,使得算力需求呈爆炸式增长。虽然多核(例如 CPU)/ 众核(例如 GPU)并行加速技术也能提升算力,但在后摩尔时代,存储带宽制约了计算系统的有效带宽,系统算力增长步履维艰。例如,使用 8 块 1080TI 从头训练 BERT 模型需 99 天。

CPU、GPU、DSA 的存储层次和计算模式对比(来源:互联网)

扩大芯片面积(包括使用 Chiplet 技术整合多块计算芯片)虽然能提升算力,但能效制约和性能瓶颈依然存在。

由于传统架构中计算与存储分离,在计算的过程中就需要不断通过总线交换数据,将数据从内存读进 CPU,计算完成后再写回存储。这一运转方式让传统冯·诺依曼架构难以适应 GPT- 4 等 AI 计算的大算力需求的快速增长趋势。

存储墙是现代计算的主要瓶颈

在目前看,存算一体是工艺更新外最有可能提升芯片算力的技术。

存算一体 是在存储器内或附近叠加计算能力,以新的高效运算架构进行二维和三维矩阵计算的技术。存算一体具有的优势包括可以实现更大算力(1000TOPS 以上)、实现更高能效(超过 10-100TOPS/W),从性能和成本优势上超越同工艺代的传统 ASIC 算力芯片。存算一体具有典型的 降本增效优势(可超过一个数量级),可减少数据搬运(降低能耗至 1 /10~1/100)。

在存算一体电路结构中,存储单元可具备一定计算能力(等效于在面积不变的情况下规模化增加计算核心数,或者等效于提升工艺代),存储单元整合一定的计算能力,具有面积更小带宽更大的结构特点。随着存算一体技术的进步,通过新的存内计算和存内逻辑,已经可以完成 32 位以上的任意高精度计算,普遍适用于从端到云的各类计算需求。

CPU、GPU 和存算一体 DSA 芯片的架构对比

从目前 GPT- 4 的部署需求来看,GPT- 4 大模型具有 数据量大、数据带宽要求高、算力要求高 的计算特点,且 算法相对单一 。如果要提高计算效率和性价比,就应该像超算那样选择更高计算密度的算力芯片。从这个角度上看,具备存算一体结构的 DSA 可以很好的满足这些要求,并且具备比现有 GPGPU 更高的计算性能,未来很有可能与 CPU 或 GPU 组合,形成 GPT- 4 这类算法的 主要部署芯片。

当然,也并不是所有的存算一体技术都适合大算力的计算。例如有些存算一体技术目前做不到大算力,还有些存算一体技术还未解决噪声和温漂问题。使用者在选择存算一体芯片时应根据算法和算力的需求选择更合适更先进的存算一体计算芯片产品。

5.4.5 大算力芯片架构的对比

从 算力 来说,DSA(存内逻辑)> GPGPU(DSA/Tensor Core+ 近存架构)> 常规 DSA ≥ 常规 GPGPU > CPU。

从 训练或计算灵活性 来说,CPU > 常规 GPGPU > GPGPU(DSA/Tensor Core+ 近存架构)> 常规 DSA ≥ DSA(存内逻辑)。

从目前 ChatGPT 与 GPT- 4 的算力需求来看,由于高度灵活的生态,GPGPU 很可能仍然在近期统治大模型训练市场,而在部署方面,基于存算一体技术的 DSA则具备非常明显的成本和性能优势,有望挤占大模型部署的市场;而常规的 DSA 由于性能上不一定能超过带有 DSA 核心的 GPGPU,除了成本优势外,不一定能直接代替 GPGPU 在模型部署领域的地位。

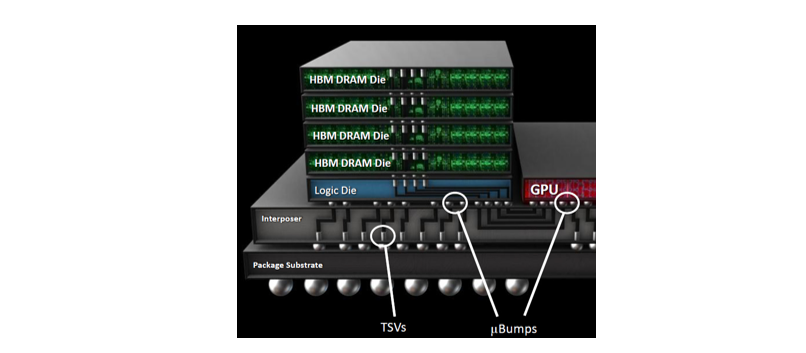

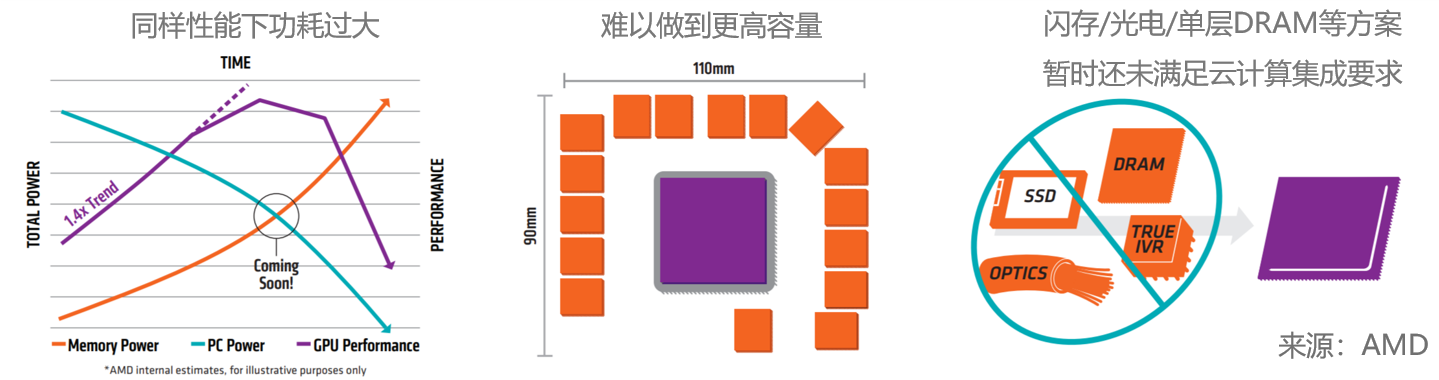

5.4.6 HBM 与 Chiplet

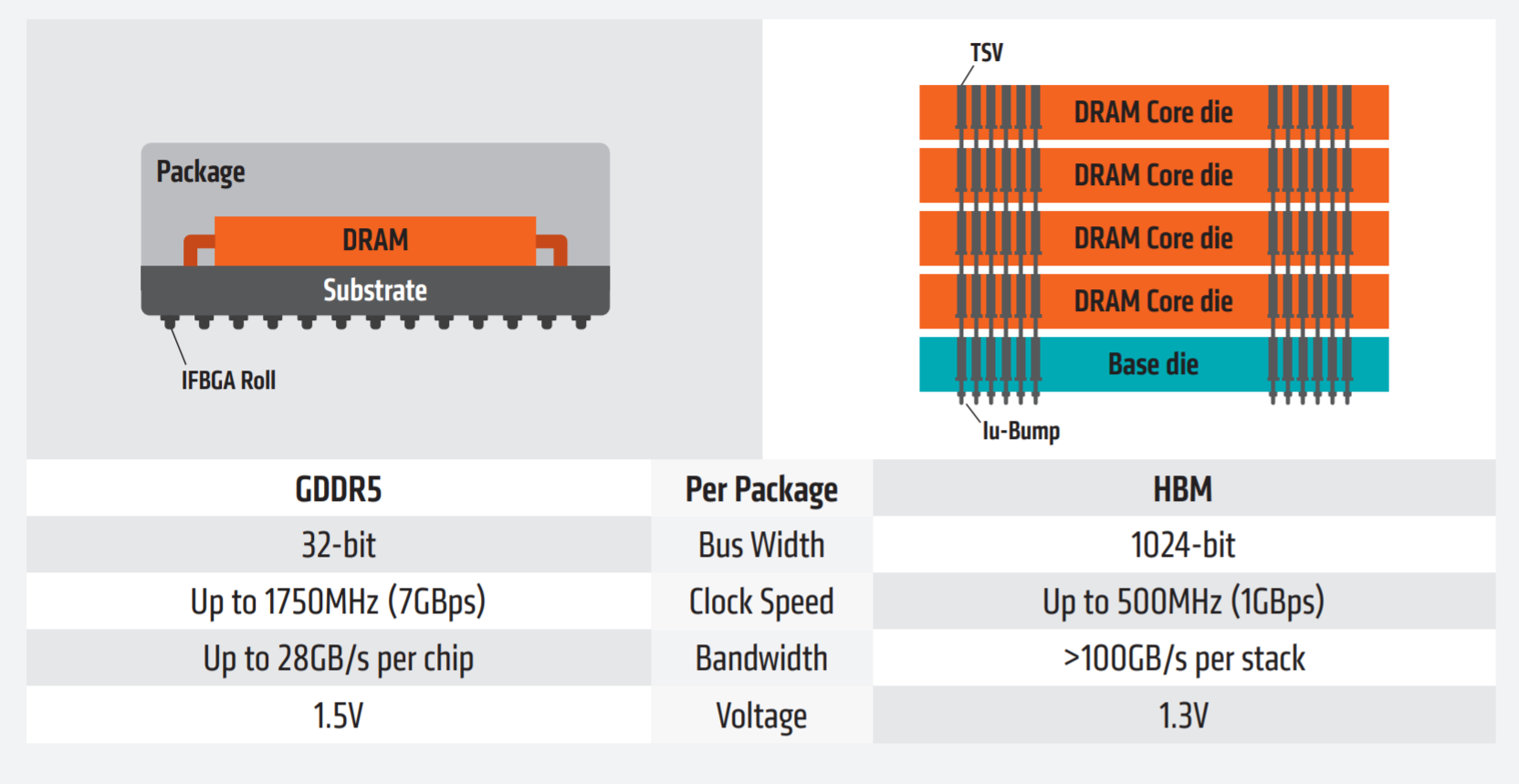

HBM(High Bandwidth Memory)是通过三维结构与计算裸片堆叠在一起的大容量高位宽 DRAM 阵列,主要用作 GPU 或 CPU 封装内部的高速内存。

HDM 结构示意(来源:AMD)

传统 DRAM 和闪存技术在大算力应用中的不足

HBM 一般通过 Chiplet 技术与 GPU 或 CPU 进行整合。绝大部分的 Chiplet 技术也用于 HBM。HBM 是 近存计算架构 的典型代表。通过增加带宽,扩展内存容量,让更大的模型,更多的参数驻留在离计算核心更近的地方,从而减少参数 / 数据存储带来的延迟。

GDDR 技术与 HBM 技术的结构对比(来源:AMD)

5.5 Infiniband 技术

Infiniband技术对于大模型的训练至关重要。Infiniband 技术的关键在于摒弃了传统网络和应用程序之间消息传递的多层 复杂结构,使应用程序之间直接进行通信,绕过了操作系统延迟,大大提高了效率。

而 Infiniband 所基于的 OpenFabrics Enterprise Distribution (OFED)是一组开源软件驱动、内核代码、中间件和支持 InfiniBand Fabric 的用户级接口程序。开放和高性能 使得 Infiniband 成为集群数据交互的事实标准。

IB 的通信堆栈

对 NVIDIA 的 GPGPU 来说,A100 或 H100 可以直接访问服务器 Infiniband 结构,通过 Infiniband 提升服务器间的数据交互带宽,而大带宽的 Infiniband 一般通过 光纤 连接(使用 SerDes 技术)来减少损耗。Infiniband 网络基于“以应用程序为中心”的观点,目标是让应用程序访问其他应用程序以及存储尽可能的简单、高效和直接,避免网络分层带来的延迟。这种结构大大提高了 GPT- 4 训练的速度。

Infiniband 基于易于使用的消息服务,该服务可以被用来与其他应用程序、进程或者存储进行通信。应用程序不再向操作系统提交访问其他资源的申请,而是直接使用 Infiniband 消息服务。

IB 的网络结构(来源:互联网)

在 GPT- 4 这类大模型训练和微调中,一般需要使用 Infiniband 这类服务器互连技术进行大算力芯片间的协同工作,整合海量芯片的算力。

主要参考文献

[1] Narayanan D , Shoeybi M , Casper J , et al. Efficient Large-Scale Language Model Training on GPU Clusters[J]. 2021.

[2] Patterson D , Gonzalez J , Le Q , et al. Carbon Emissions and Large Neural Network Training[J]. 2021.

原文链接:https://zhuanlan.zhihu.com/p/611464068