导语:

当百度在今年 3 月 16 日率先在国内公开生成式大模型文心一言内测时,包括笔者在内的一部分业者,都觉得似乎仓促了些,效果不算尽善尽美。

但站在今天这个档口,也就是文心千帆内测的时刻,再回去看当时的决策,又会觉得百度非常善于把握机会。

率先推出,就有率先收获第一批客户的机会。在目前群“模”乱舞的当下,这个窗口期拿捏的恰到好处。

当然,真正决定生成式大模型能否“落得下来”和“立得住”的,还是是否满足了用户的需求,解决了具体的痛点。

在 AI 商业化落地的大局面迟迟没有彻底打开的当下,生成式模型的出现,仿佛天启,对 AI 落地来了一次神助攻。

但如果没有踏实的服务能力和对客户需求的精准把握,再好的大模型也难言胜算。

笔者访谈了多位业内人士,他们对以文心一言为代表的生成式大模型探索商业化落地,给出了许多真知灼见。

1、贵客盈门

百度内测文心一言大模型后,在上海、北京办了两次名为“技术交流会”的闭门会议。

所谓的“技术交流会”,其实就是客户会。据说此前在上海办的一场,参与者多到无法下脚。

而北京的这一场也不例外,会场被挤的水泄不通。更重要的是,我看到了很多的、不同企业的老熟人、老朋友。

这么多的人来,目的只有一个——探讨如何尽快的接入文心一言,把生成式大模型的能力用起来。

这让我非常感概,因为自从 alpha go 战胜人类棋手,象征着 AI 进入公众视野并成为一个重要风口以来,一个核心问题一直存在,就是 AI 的商业化落地效率不尽如人意。为此,我还专门写过一篇文章探讨这个问题(AI 落地的范式创新,比一个 ChatGPT 更激动人心)。

从现在的角度回头看 3 月的文章,其实该文有一个重要的缺点就是——我一直是按线性发展去预测 AI 的落地规律,但没有考虑到 chatGPT 这种奇点的出现。

文心一言(其大模型服务平台叫文心千帆,下同)哪怕还不完美、哪怕还被人喷……这都不要紧,现场的贵客盈门、观者如堵,说明了一个问题——当真正的机会到来时,能发现机会的聪明人是从来都不缺少的。

也许,多年以后我们回顾 AI 发展史,会把这一天真正的定义为 AI 商业化落地大浪潮的“D 日”。

那这么多人都来看什么呢?来看的就是正在内测的“文心千帆大模型平台”。

按照百度的官方说法,文心千帆是全球首个一站式的企业级大模型生产平台,不但提供包括文心一言在内的大模型服务及第三方大模型服务,还提供大模型开发和应用的整套工具链。

是不是全球第一,我不敢断言。但可以肯定的是,围绕用户如何高效、低成本得获取大模型能力,以及如何挑选到最合适的大模型服务,甚至在没有独立开发大模型能力的情况下,把大模型导入自己的领域做私有化部署并发挥作用,文心千帆是最早给出答案的。

就凭这一点,文心千帆至少又在国内市场上,为百度争夺到了 3 - 6 个月的机会窗口期。

用白话说就是,文心千帆可以干两件事:

第一,百度把文心一言放到了云上,使得文心千帆可以以文心一言为核心提供大模型服务,帮助客户改造产品和生产流程,这是“直接用”。

第二,作为一个大模型生产平台,企业可以在文心千帆上基于任何开源或闭源的大模型,开发自己的专属大模型,这是“间接用”。还顺便给百度的“云智一体”打了一个最好的广告。

那么,文心千帆真的可以帮助企业快速运用大模型的能力开展业务么?

2、难与痛

在客户会的现场,我们可以看到很多熟悉的企业,比如全球 PC 老大联想、国内办公领域的老大金山办公、比如国内 ERP 市场的老大用友网络……这些企业到现场来,并不是仅仅捧场的。

为什么这么说呢,因为来的大都是技术负责人,而不是企业的 CEO。

管技术的人来开会,也从某个侧面说明了,一部分先知先觉的国内企业已经在很短的时间里解决了“要不要用”的下决心问题,而已经开始关注“怎么用”的问题。

那么,为什么如此多的企业,甚至是我们认为技术实力很强大的一些企业,都要来关注如何用文心千帆呢?

某种程度上,是这段时间内的群“模”乱舞,给了我们一定程度上的错觉——好像大模型谁都可以做,谁都能做好、用好。

行业内似乎有一种很轻松的论调,认为——1000 张卡、10 亿美金、100 人以内的团队,3 个月就可以做出一个千亿级大模型。

这话倒也不完全错,毕竟国际上开源模型很多,拿来套个壳很容易,但是好不好用就没法说了。

就比如,我也相信楼下修车铺的老师傅,我给他足够多的时间和零件,他能攒出一台可以开动的汽车来……但是,如果我是要用这辆车去参加巴黎 - 达喀尔拉力赛呢?

事实上,国内业界能达到世界级水平的生成式大模型,目前看来最多一只手就数得出来。所谓的“千卡开模”,只是一个入门的通俗说法。据我了解,目前 bat 在生成式大模型上投入的 A100 级别的卡,就没有一家是少于 1 万张的,而且上不封顶。

这已经把 99% 的企业拦在了外面,但这还不是最重要的。

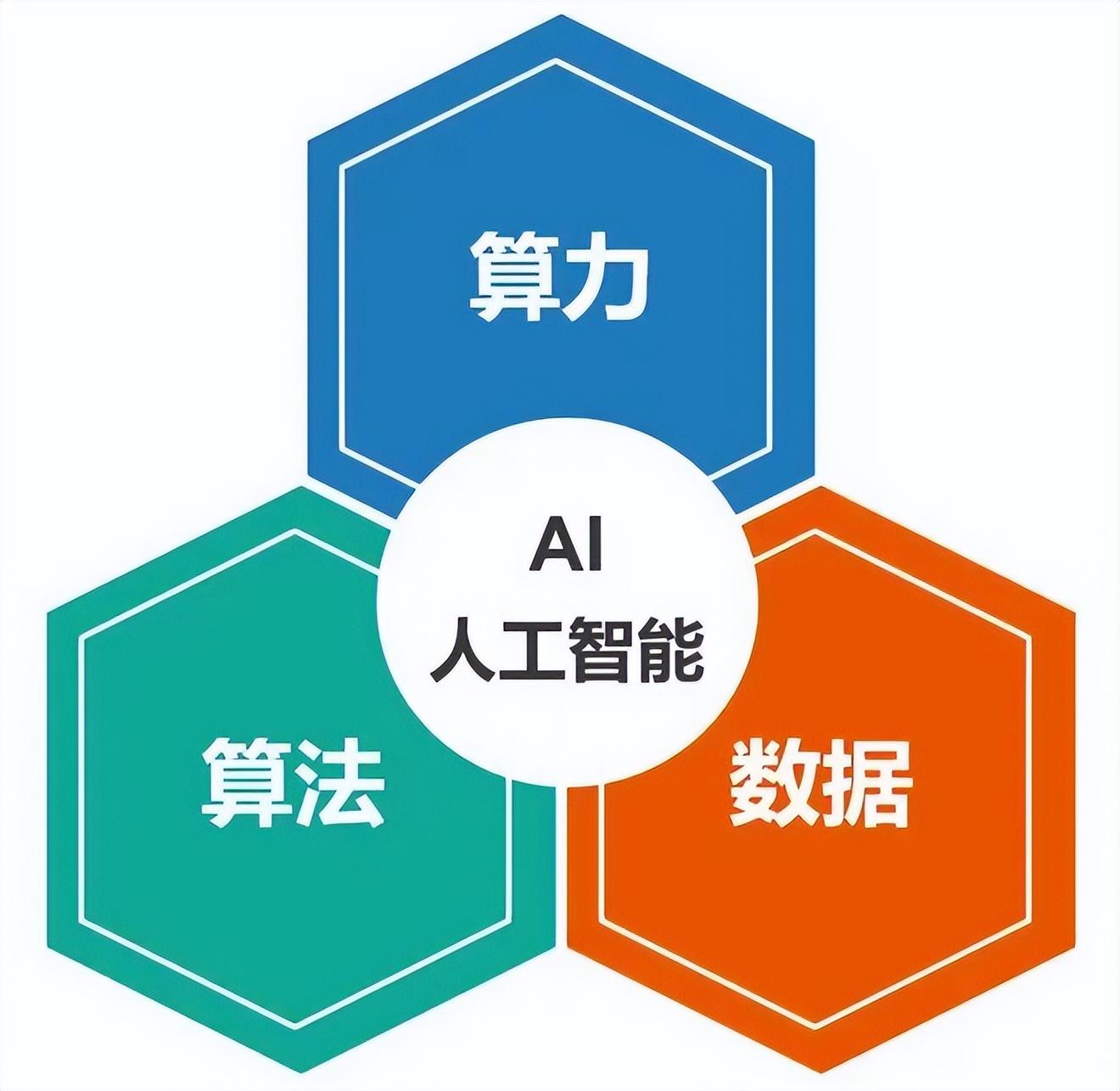

重要的是,我们要仔细从“数据、人才、场景”三个角度,看看国内生成式大模型投入应用的实际痛点和难点。

首先说 数据。现场的说法是,起步的数据是 500GB 数据、2500 亿字的文本语料。

而这只是指的在文心大模型的基础上,训练一个行业大模型需要的起步数据量,并不是具有通识能力的 AGC(通用人工智能)大模型。

而中文语料也不是光是字数多就可以,要的是精品内容,比如论文、书籍、研报、专业资料等等……用一个最通俗的比喻就是,起码达到百度百科或者知乎上高赞回答的程度。

我举一个例子,前不久,我国某高校的一个开源大模型在国际上的一个著名榜单上排行第五(这个排位已经很高了),它用的是什么训练数据集呢?

官方资料显示,用的是一个包含超过 1000 亿词汇量的中英双语数据集进行预训练。该数据集涵盖了各种类型和领域的文本数据,包括新闻、百科、社交媒体、小说、电影剧本等。

业内的说法是,真正的核心数据,来自国际上两个已经经过 20 多年打磨的开源数据集,一个是法律方向的,一个是生命科学方向的。

为了让这些训练数据为中文大模型所用,对中文做针对性优化,据说发动了近千名的大学生,逐条校对翻译结果,最后才达到良好的训练效果。

那你问我有没有金融、艺术、汽车、旅游……等等的开源数据集,抱歉真的没有,就算有,也没有达到上面两个训练数据集这个水准的。

所以,对于大多数想用好文心大模型(还只是用好,而不是开发)来训练行业大模型的企业,要过的第一关就是数据关。为什么金山、用友这些企业很积极,因为它们创立时间久,积累的专业数据量多,这就是优势。

接下来,说一点 人才方面 的问题。

这次开会我遇到了一个企业的高管,他告诉我说,他这次来也是为了引入文心千帆去打造自己所在行业的大模型的。

我问他,你们企业有多少程序员。他告诉我,有 5000+。

我很惊讶的问,有这么多人才,还不能自己开发?

他的回答是,搞大模型的人是贵精不贵多,openAI 的员工长期只有 100 多人(现在接近 500 了),而其中搞大模型核心的不过 20 多个人。

而我们看看欧美大厂——亚马逊从事人工智能领域的员工最多,有 10113 人;微软在人工智能领域有 7133 名员工,而谷歌有 4970 名(以上都是专职的 AI 开发人员,不是泛指的软件工程师)。而 openAI 搞出 ChatGPT 时只有 154 人。

把视角切换到国内,咱们就不说能开发大模型的人,就说能把大模型引入行业内落地的人,平均下来有多少?

最后说的是 场景。

现在有一句话又流行起来了,叫“用 ChatGPT 把所有领域重做一遍”。

这句话很上头,但如果把时间线拉到 20 年,我觉得都不一定能成。

比如,大家觉得,大型政企机构有钱、有人、有多年积累的数据,是较好的能够落地的机构。

但事实上,一个特大型机构落地一个新技术体系,本身就很难,特别是前沿的数字技术。绝大多数特大企业的信息化建设都很早,多年来的累积建设,如同叠屋架床,体系非常复杂。如果是在体系外围做单点式创新还不算难,但如果要把 AI 技术融入大企业、大行业的技术底座,其复杂性难以想象,其失败也是有相当概率的。

简单说就是,安排什么场景,重点发力什么场景,这些都要又结合“人才、数据、场景”三要素,重新推敲一遍。

可能读者看到这里就要问了,你把问题说的那么多、痛点那么多,你到底是鼓励,还是劝退呢?

这就是接下来我要说的,文心千帆要是想生存下去、发展起来,就要帮助行业解决这些难题和痛点,这就是它的机会,也是它的考验。

3、文心千帆真的让事情简单了么?

文心千帆的核心能力是什么?

核心能力是处处从用户的需求出发。

我们之前说过,99% 的企业会因为成本问题遇到挑战。

笔者当天在现场和负责文心千帆的百度集团副总裁侯震宇聊了一会,他说的一番话,让我印象深刻。他说:“对企业来说,做大模型可能有点贵,但用大模型没有那么贵。现在文心一言(推理)的成本只有之前的十分之一了,以后还会降。”

为什么呢?很多人会疏忽掉大模型的全称,全称叫“预训练大模型”。

换句话说,就是大模型在面向实际任务建模前,需在海量通用数据上进行预先训练,能大幅提升 AI 的泛化性、通用性、实用性。

也就是说,拿给你用的时候,是训练好的模型,这就已经帮你省了很多钱和很多事。而且,不管是做再训练还是微调,所使用的数据规模和处理数据的算力规模,都和从零开始训练千亿大模型完全不在一个量级上。

这就是“前人栽树,后人乘凉”。

但是,有一个问题是,大模型虽然有极强的泛化能力和通用能力,但进入任何一个具体行业,还是要对于行业特性进行精细的优化,其中根据调整参数的多寡,成本各自不同。

但是,能够调,和不能够调,对最终的效果影响巨大。而即使是微调,也有很高的技术门槛。

所以,文心千帆演示的一个非常重要的功能就是——微调。

而且,是百度智能云 AI 与大数据平台总经理忻舟亲自在现场演示的。

据我所知,这也是国内首次公开演示如何微调行业专属大模型的全过程。

和很多人想象的满屏都是各种命令符和代码不同,这个微调是完全在可视化的图形界面下完成的,而且因为具有了可视化的开发工具链,使得用户能够轻松的使用数据生成、标注、回流等功能,形成了围绕数据的闭环管理。

说人话就是,用户以少量数据即可发起模型微调,最快几分钟就可获得自己的专属大模型。

从开始演示到结束,我看了一下表,忻舟用了 70 秒钟的时间。

当然,拿出来演示的,可能是一个相对比较通用、简单的场景,但这已经足以让在场的观众惊叹,以至于演示结束后,现场响起了掌声。

为什么?这意味着大部分用户单位,都可以自己搞定微调问题。

打个比方就等于,不能进行可视化微调的大模型,就相当于你买了一台超级计算机,得有几十上百的专业人士去做调试;后者,就相当于你买了一台电视机,自己看看说明书,动手调调就可以看了。

对于 AI 人才极为金贵稀缺的当下,这相当于把“微调自由”还给了企业,让企业真正可以掌握自己的行业大模型,我相信这是文心千帆的一个非常重要的功能。

每家企业都希望用到大模型。就好像是家家都需要用电;但文心千帆的出现,就使得没有必要每家都搞一个电厂,也没有必要每家都置办一个发电机,也同样可以安全放心的使用大模型能力。

最后我还要强调一个特点就是,因为百度“云智一体”的能力,百度智能云可以完美的承载和分发大模型的能力,这使得百度智能云的价值提升了,更使得大模型的快速普及有了可能性。

比如,你用公有云模式,那就再简单不过。你可以直接调用大模型的推理能力,也可以基于自己的需求微调,从而通过高质量的精心标注,高效训练出特定行业的大模型;你甚至不建设机房,直接用托管模式,将模型发布在百度智能云,以实现更加稳定高效的运行。

不过,笔者在现场和几个行业的代表聊了聊,他们中的不少人都认为,私有化部署,也很有吸引力,特别是对数据监管有严格要求的企业。

为什么呢?这就和目前国际上很多金融、高科技制造业纷纷禁止员工在业务中使用 chatgpt 有关。

比如,某个投行的一个经理,把一份写好的研报交给 chatgpt 修改。那么,在一定概率上,这部分研报就可能成为 chatgpt 自我训练的一个内容,进而可能泄密。

所以在这种情况下,文心千帆也支持私有部署,其中,软件授权模式比较接近于传统软件的授权模式,直接提供在企业环境中运行的大模型服务;或者干脆购买整合了大模型服务和硬件的一体机,甚至还可以租用,针对那些不是那么高频的用户。

客观说来,这次发布比文心一言的发布,更令人感到冲击。如果说后者主要是功能上的炫酷,前者就是商业模式上以用户为需求的精心设计。

和很多很酷但还在路上的大模型相比,文心千帆已经把模型开发、训练、调优、运营等复杂过程封装起来,成为了成熟的产品。其具有的海量数据处理、高质量数据标注、再训练 / 微调 / 强化学习、大模型评估及高效压缩、自动化 prompt 工程、快速应用编排等能力,都极大的降低了企业在数据、成本、人才上的需求,使得用户可以直视场景,根据行业的特性和需求,充分而自由的使用“模型及服务”的能力,真正的实现“大模型自由”。

同时,由于百度是全球唯一在芯片、框架、模型和应用这四层进行全栈布局的人工智能公司,层与层之间顺畅的配合,可以推动大模型快速迭代升级。这将成为百度智能云的超级差异化竞争点,为这个一直在寻找弯道超车机会的业务,提供了重要的推力。尽管一切也许还不够完美,但这条路径的正确,似乎无可争议。

某种意义上,这是百度自 20 年前启动搜索后之后,遇到的又一个命运级的机会窗口,如果百度能够用自己的大模型能力深度赋能社会,不仅百度自身会获得更好的发展,也为中国的智能化浪潮提供了一个世界级的引擎。

原文链接:https://www.bilibili.com/read/cv23659345/